MiniMind:2小时从零训练26M参数的小型GPT!

你是否曾经被大语言模型高昂的训练成本和复杂的实现细节所困扰?MiniMind 的出现,旨在彻底解决这个问题。它是一个完全从零开始、使用 PyTorch 原生代码实现的小型语言模型项目,可以帮助开发者和学习者在极低的成本下,亲身体验从零构建语言模型的全过程。本文将带你全面了解这个潜力新星。

截至收录:

MiniMind项目stars数:28134

MiniMind项目forks数:3307

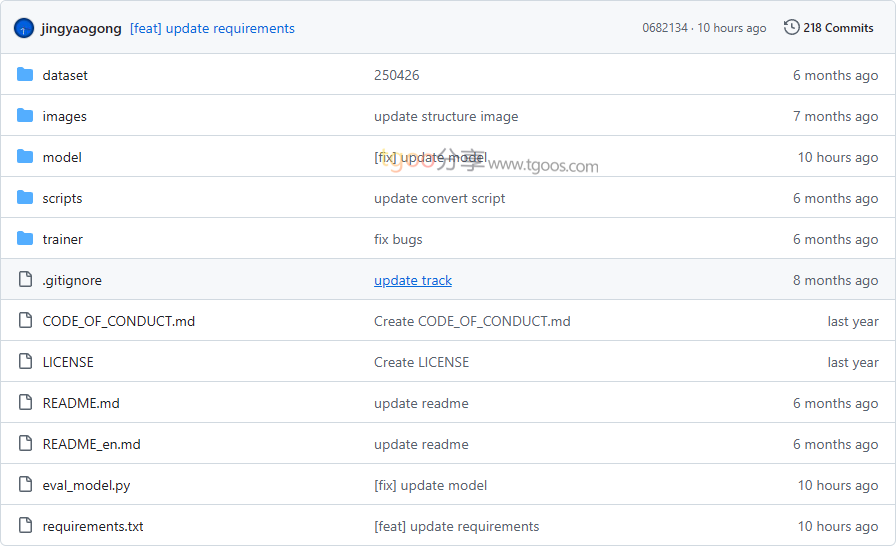

MiniMind项目目录截图

MiniMind项目核心亮点

- 🚀 极低成本训练:仅需3元人民币和2小时时间,即可在单张NVIDIA 3090显卡上完成26M参数模型的训练。

- 🧩 全流程开源:涵盖预训练、监督微调、LoRA、DPO强化学习、模型蒸馏等大模型训练全阶段代码。

- 📚 高质量数据集:提供经过精心清洗和整理的中英文训练数据集,全部开源可用。

- 🔧 原生代码实现:所有核心算法均使用PyTorch原生代码从零实现,不依赖第三方抽象接口。

MiniMind项目快速开始

只需几步,你就能在本地运行起 MiniMind:

1. 环境准备:

git clone https://github.com/jingyaogong/minimind.git

cd minimind

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple- 测试已有模型:

git clone https://huggingface.co/jingyaogong/MiniMind2 python eval_model.py --load 1 --model_mode 2 - 从零开始训练:

cd trainer python train_pretrain.py # 预训练 python train_full_sft.py # 监督微调

MiniMind项目应用场景

- LLM学习入门:为初学者提供完整的大语言模型学习路径,从理解每一行代码开始。

- 低成本实验验证:研究人员可以用极低成本验证新的训练方法和模型架构。

- 垂直领域定制:通过LoRA等技术快速为特定领域定制专用模型。

- 教学演示:教育机构可以用作人工智能和自然语言处理课程的实践教材。

用户案例:目前已有众多AI学习者和研究者在使用 MiniMind 来深入理解大语言模型的内部机制。

MiniMind项目链接

jingyaogong / minimind项目地址:https://github.com/jingyaogong/minimind

本文地址:https://www.tgoos.com/17069

声明:本站资源均整理自互联网,版权归原作者所有,仅供学习交流使用,请勿直接商用,若需商用请购买正版授权。因违规使用产生的版权及法律责任由使用者自负。部分资源可能包含水印或引流信息,请自行甄别。若链接失效可联系站长尝试补链。若侵犯您的权益,请邮件(将 # 替换为 @)至 feedback#tgoos.com,我们将及时处理删除。转载请保留原文链接,感谢支持原创。