Qwen3-VL:阿里云通义千问团队打造的最强多模态大模型系列

你是否曾经为传统AI模型在视觉理解、文本生成和跨模态推理方面的局限性而困扰?Qwen3-VL的出现,旨在彻底解决这个问题。它是阿里云通义千问团队开发的多模态大语言模型系列,可以帮助开发者和研究人员实现图像、视频与文本的无缝融合理解与生成。本文将带你全面了解这个潜力新星。

截至收录:

Qwen3-VL项目stars数:14842

Qwen3-VL项目forks数:1142

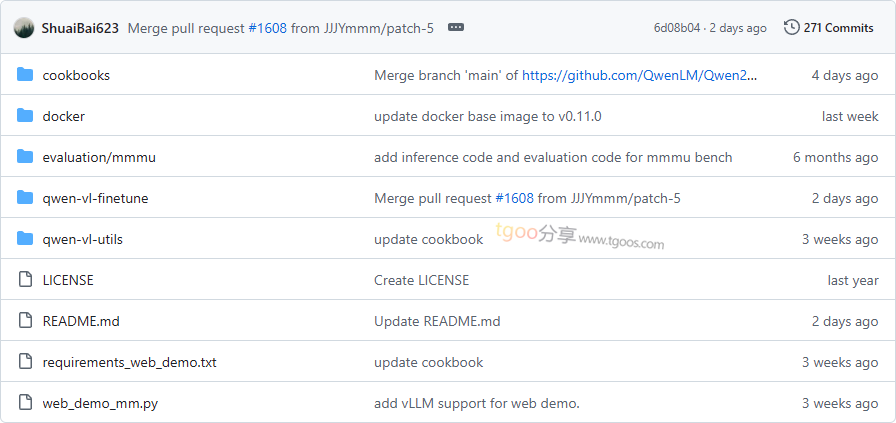

Qwen3-VL项目目录截图

Qwen3-VL项目核心亮点

🌟 极致多模态能力:全面升级的视觉感知与推理能力,支持图像、视频、文档等多种模态输入,在文本理解与生成方面媲美纯文本大模型。

🎯 强大的视觉代理功能:能够操作PC/移动端GUI界面,识别界面元素、理解功能、调用工具并完成任务执行。

🔒 先进的架构设计:采用Interleaved-MRoPE位置编码和DeepStack多级特征融合技术,显著提升长视频推理和细粒度细节捕捉能力。

🧩 灵活的可扩展性:提供从边缘到云的密集和MoE两种架构,支持Instruct和Thinking推理增强版本,满足不同部署需求。

Qwen3-VL项目快速开始

只需几步,你就能在本地运行起 Qwen3-VL:

- 安装依赖:

pip install git+https://github.com/huggingface/transformers pip install qwen-vl-utils==0.0.14 - 运行第一个示例:

from transformers import AutoModelForImageTextToText, AutoProcessormodel = AutoModelForImageTextToText.from_pretrained( "Qwen/Qwen3-VL-235B-A22B-Instruct", dtype="auto", device_map="auto" ) processor = AutoProcessor.from_pretrained("Qwen/Qwen3-VL-235B-A22B-Instruct") messages = [ { "role": "user", "content": [ { "type": "image", "image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg", }, {"type": "text", "text": "Describe this image."}, ], } ] - 查看生成结果:

inputs = processor.apply_chat_template(messages, tokenize=True, add_generation_prompt=True, return_dict=True, return_tensors="pt") generated_ids = model.generate(**inputs, max_new_tokens=128) output_text = processor.batch_decode(generated_ids_trimmed, skip_special_tokens=True) print(output_text)

Qwen3-VL项目应用场景

场景一:智能文档解析:企业可以使用Qwen3-VL自动识别和解析各类文档,包括发票、合同、报告等,提取关键信息并生成结构化数据。

场景二:视频内容理解:内容平台可以利用其强大的长视频理解能力,对小时级别的视频进行秒级索引和内容分析,实现智能视频检索和摘要生成。

场景三:视觉编程助手:开发者可以通过上传界面截图,让模型自动生成Draw.io图表、HTML/CSS/JS代码,大幅提升开发效率。

用户案例:目前,阿里云内部多个产品线、以及众多科研机构和企业在使用 Qwen3-VL 来改善其多模态AI应用的工作流。

Qwen3-VL项目链接

QwenLM / Qwen3-VL项目地址:https://github.com/QwenLM/Qwen3-VL

本文地址:https://www.tgoos.com/17794