llama.cpp:在C/C++中实现高效的LLM推理

你是否曾经为运行大型语言模型需要复杂的Python环境和昂贵的GPU资源而烦恼?llama.cpp的出现,旨在彻底解决这个问题。它是一个用纯C/C++编写的轻量级推理引擎,可以帮助开发者在各种硬件上高效运行大型语言模型。本文将带你全面了解这个性能卓越的开源项目。

截至收录:

llama.cpp stars数:87765

llama.cpp forks数:13331

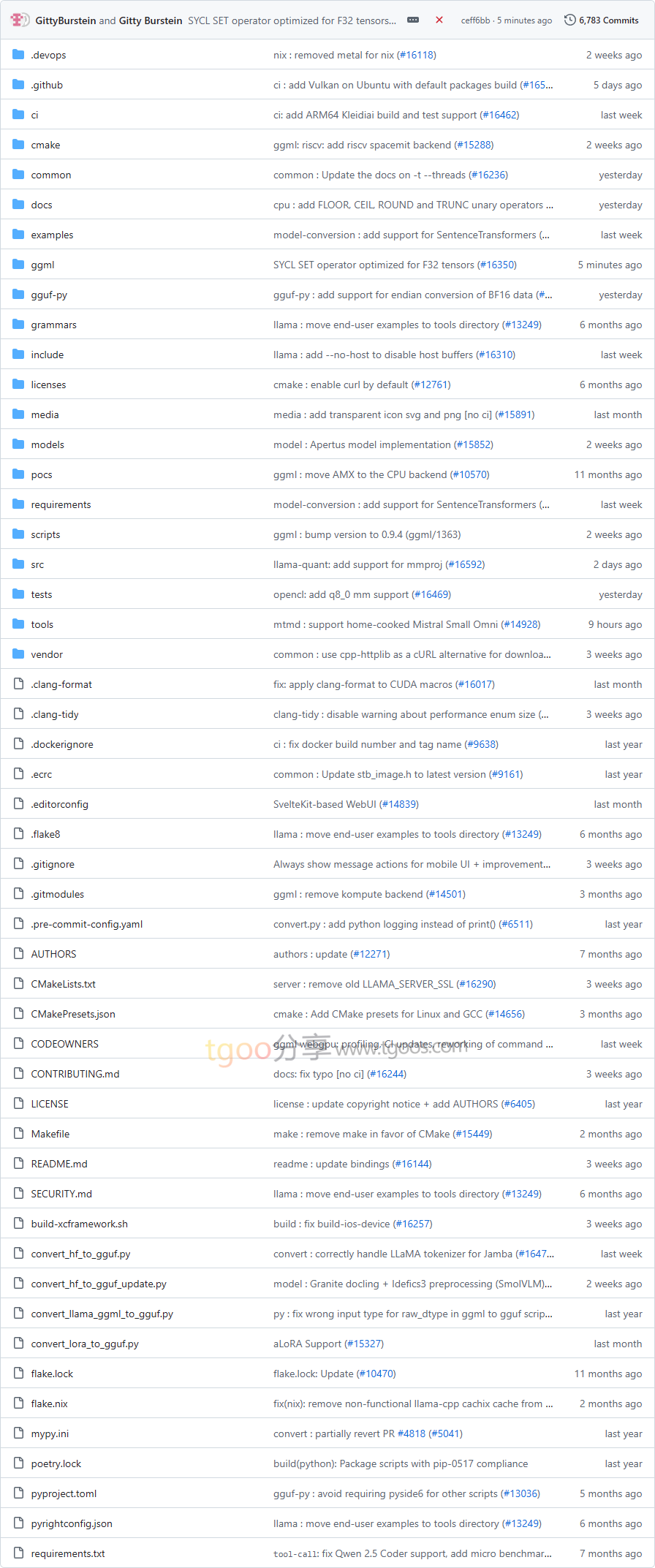

llama.cpp项目目录截图

llama.cpp核心亮点

🚀 极致性能:针对不同硬件深度优化,支持Apple Silicon的Metal框架、x86架构的AVX指令集,以及多种GPU后端。

📦 开箱即用:提供多种安装方式,包括预编译二进制文件、Docker镜像和包管理器安装,无需复杂配置。

🔧 灵活量化:支持1.5位到8位的多种整数量化方案,显著降低内存占用并提升推理速度。

🌐 广泛兼容:支持多种硬件后端,包括NVIDIA CUDA、AMD HIP、Vulkan、SYCL等,覆盖主流计算设备。

llama.cpp快速开始

只需几步,你就能在本地运行起llama.cpp:

- 安装:

# 使用包管理器安装 $ brew install llama.cpp # 或下载预编译二进制文件 # 或使用Docker运行 - 运行你的第一个命令:

# 使用本地模型文件 $ llama-cli -m my_model.gguf或直接从Hugging Face下载并运行模型

$ llama-cli -hf ggml-org/gemma-3-1b-it-GGUF - 启动API服务器:

$ llama-server -hf ggml-org/gemma-3-1b-it-GGUF --port 8080

llama.cpp应用场景

边缘设备部署:在资源受限的设备上运行LLM,实现真正的本地AI推理,保护用户隐私。

云端服务:通过OpenAI兼容的HTTP服务器,快速构建LLM服务API,支持多用户并发访问。

模型评估:使用内置的perplexity工具评估模型质量,为模型选择提供数据支持。

开发集成:提供XCFramework支持,方便在iOS、macOS等苹果生态中集成LLM功能。

用户案例:目前,该项目已被广泛应用于各种AI应用场景,支持从Hugging Face、ModelScope等多个平台下载和运行模型,为开发者提供了统一的推理解决方案。

llama.cpp链接

ggml-org / llama.cpp项目地址:https://github.com/ggml-org/llama.cpp

本文地址:https://www.tgoos.com/18234