Tinker Cookbook:简化大语言模型微调的完整解决方案

你是否曾经为大语言模型的复杂微调流程感到头疼?Tinker Cookbook 的出现,旨在彻底解决这个问题。它是一个基于 Tinker API 的微调配方库,可以帮助开发者和研究人员轻松实现从监督学习到强化学习的各种模型定制需求。本文将带你全面了解这个潜力新星。

截至收录:

Tinker Cookbook stars数:1492

Tinker Cookbook forks数:118

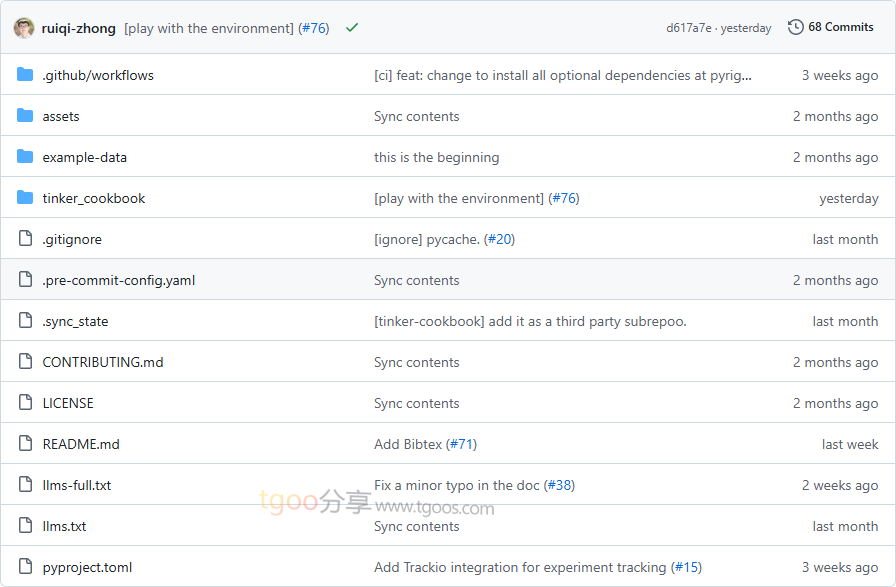

Tinker Cookbook项目目录截图

Tinker Cookbook核心亮点

🌟 完整的微调生态:提供从基础 API 到高级配方的完整解决方案,覆盖监督学习、强化学习等多种训练场景。

🎯 开箱即用的配方:内置丰富的实用示例,包括数学推理、工具使用、多智能体训练等真实场景,无需从零开始。

🔒 企业级训练支持:基于 Tinker SDK 提供分布式训练支持,自动处理训练复杂性,让用户专注于模型优化。

🧩 模块化设计:提供渲染器、超参数工具、评估工具等实用模块,支持灵活组合和自定义扩展。

Tinker Cookbook快速开始

只需几步,你就能开始使用 Tinker Cookbook 进行模型微调:

- 安装准备:

# 申请 Tinker 访问权限并通过等待列表 # 获取 API 密钥并设置为环境变量 export TINKER_API_KEY=your_api_key # 安装 Tinker Python 客户端 pip install tinker # 安装 Tinker Cookbook pip install -e . - 运行第一个微调示例:

import tinker service_client = tinker.ServiceClient() training_client = service_client.create_lora_training_client( base_model="meta-llama/Llama-3.2-1B", rank=32, ) - 探索高级配方:

# 查看监督学习示例 python tinker_cookbook/recipes/sl_basic.py

Tinker Cookbook应用场景

场景一:对话模型优化:开发者可以使用配方库对对话数据集进行监督微调,提升模型的对话质量和一致性。

场景二:数学推理增强:通过强化学习奖励机制,训练模型在数学问题解答中的推理能力,显著提升准确率。

场景三:工具使用训练:优化大语言模型使用检索工具的能力,让模型能够更准确地回答基于外部知识的问题。

场景四:多智能体协作:训练语言模型与其他模型或自身进行交互,适用于复杂的多轮对话和协作任务。

用户案例:该项目由 Thinking Machines Lab 开发,为研究社区提供了标准化的模型微调方案,适用于学术研究和工业应用中的各种大语言模型定制需求。

Tinker Cookbook链接

thinking-machines-lab / tinker-cookbook项目地址:https://github.com/thinking-machines-lab/tinker-cookbook

本文地址:https://www.tgoos.com/21542