Crawl4AI:开源LLM友好型网络爬虫与抓取工具,将网页转换为清晰的Markdown格式

你是否曾经为从网页中提取结构化数据、为RAG系统准备内容或构建AI代理数据源而感到头疼?Crawl4AI的出现,旨在彻底解决这个问题。它是一个用Python编写的开源LLM友好型网络爬虫和抓取工具,可以帮助开发者快速将网页内容转换为干净、LLM就绪的Markdown格式。本文将带你全面了解这个潜力新星。

截至收录:

Crawl4AI stars数:53240

Crawl4AI forks数:5299

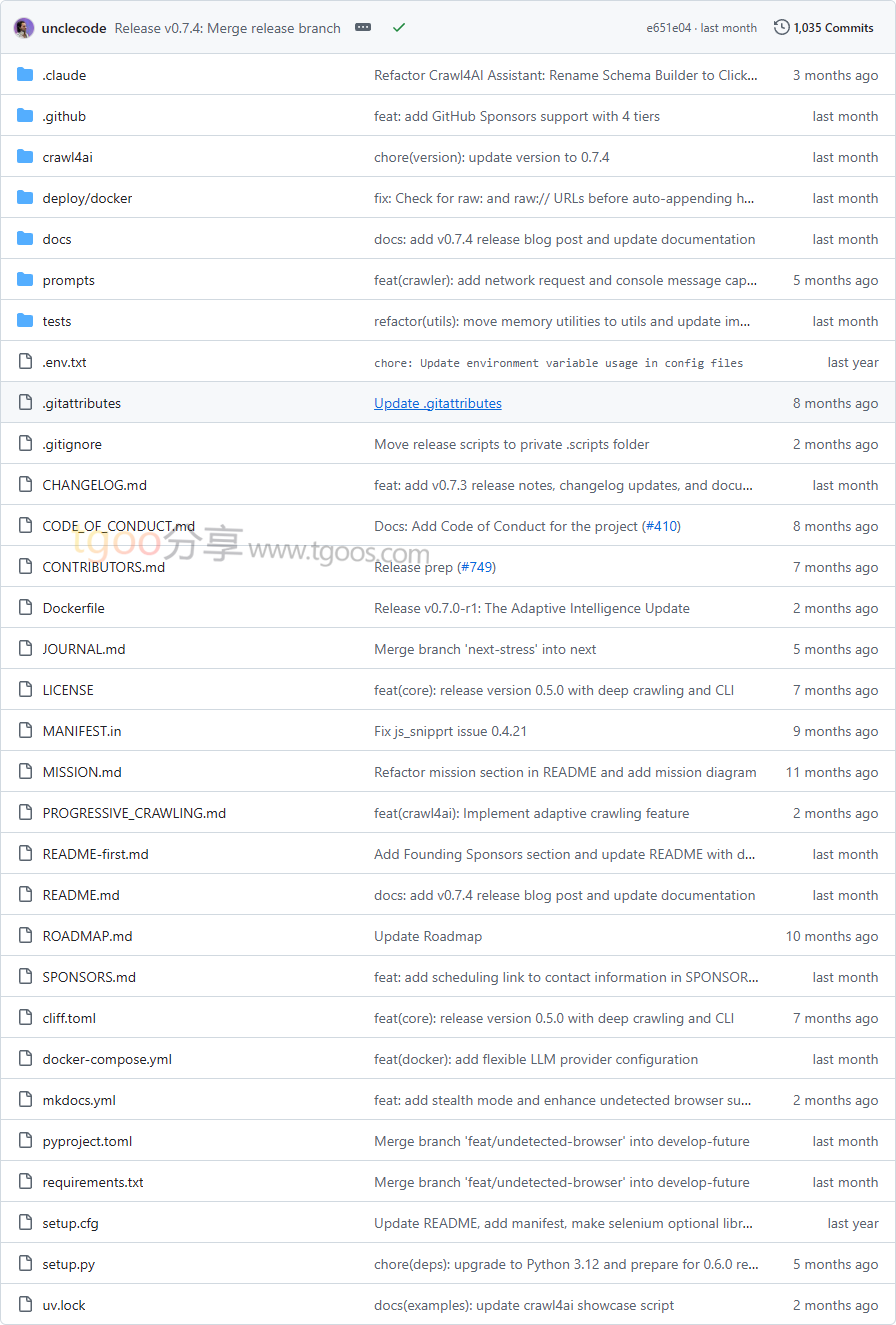

Crawl4AI项目目录截图

Crawl4AI核心亮点

🌟 文本即数据:使用先进的算法将网页内容转换为清晰的结构化Markdown,完美适配LLM处理需求。

🎯 智能表格提取:革命性的LLM表格提取技术,支持智能分块,确保数据完整性。

🔒 浏览器集成:支持无痕浏览器模式,避免被检测,提供稳定的爬取体验。

🧩 高度可配置:提供多种爬取策略(如BFS)、并发控制和内存管理,满足不同场景需求。

Crawl4AI快速开始

只需几步,你就能在本地运行起 Crawl4AI:

- 安装:

# 安装包 pip install -U crawl4ai # 运行安装后设置 crawl4ai-setup # 验证安装 crawl4ai-doctor - 运行你的第一个爬取任务:

import asyncio from crawl4ai import *async def main(): async with AsyncWebCrawler() as crawler: result = await crawler.arun( url="https://www.nbcnews.com/business", ) print(result.markdown) if name == "main": asyncio.run(main()) - 或使用命令行界面:

# 基础爬取并输出Markdown crwl https://www.nbcnews.com/business -o markdown

Crawl4AI应用场景

场景一:RAG系统数据准备:开发者可以使用它从各种网页源提取干净的内容,为检索增强生成系统准备高质量数据。

场景二:AI代理数据采集:为AI代理构建实时的网页数据源,支持智能决策和内容生成。

场景三:企业数据管道:帮助企业构建自动化的网页数据采集和处理管道,支持业务分析和决策。

用户案例:目前,已有5万多名开发者和众多企业正在使用 Crawl4AI 改善其数据工作流。

Crawl4AI链接

unclecode / crawl4ai项目地址:https://github.com/unclecode/crawl4ai

本文地址:https://www.tgoos.com/10555

声明:本站资源均整理自互联网,版权归原作者所有,仅供学习交流使用,请勿直接商用,若需商用请购买正版授权。因违规使用产生的版权及法律责任由使用者自负。部分资源可能包含水印或引流信息,请自行甄别。若链接失效可联系站长尝试补链。若侵犯您的权益,请邮件(将 # 替换为 @)至 feedback#tgoos.com,我们将及时处理删除。转载请保留原文链接,感谢支持原创。