nanoGPT:最简单、最快速的中等规模GPT训练/微调仓库

你是否曾经想要训练自己的GPT模型,却被复杂的代码和庞大的资源需求所困扰?nanoGPT的出现,旨在彻底解决这个问题。它是一个用Python编写的轻量级GPT训练框架,可以帮助开发者轻松训练和微调中等规模的GPT模型。本文将带你全面了解这个潜力新星。

截至收录:

nanoGPT项目stars数:46228

nanoGPT项目forks数:7815

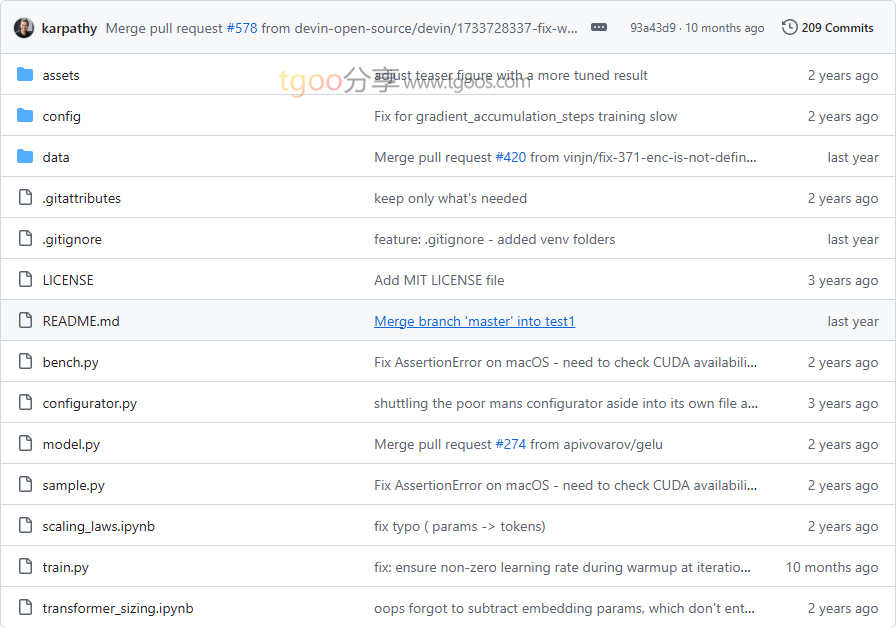

nanoGPT项目目录截图

nanoGPT项目核心亮点

🌟 极致简洁:核心代码极其精简,train.py仅约300行训练循环,model.py约300行GPT模型定义,代码清晰易读。

⚡ 训练高效:支持PyTorch 2.0编译优化,在8xA100 40GB节点上4天即可复现GPT-2(124M)模型。

🔧 灵活适配:支持从单GPU到多节点分布式训练,可根据硬件资源灵活调整模型规模和训练配置。

🔄 开箱即用:提供完整的训练、微调、采样流程,支持加载OpenAI预训练权重,快速上手无压力。

nanoGPT项目快速开始

只需几步,你就能在本地运行起nanoGPT:

- 安装依赖:

pip install torch numpy transformers datasets tiktoken wandb tqdm - 准备莎士比亚数据集:

python data/shakespeare_char/prepare.py - 开始训练:

# GPU训练 python train.py config/train_shakespeare_char.py # CPU训练 python train.py config/train_shakespeare_char.py --device=cpu --compile=False - 生成文本:

python sample.py --out_dir=out-shakespeare-char

nanoGPT项目应用场景

场景一:教育研究:学生和研究人员可以快速理解GPT工作原理,进行自然语言处理实验和模型研究。

场景二:内容生成:开发者可以基于特定领域数据微调模型,生成符合业务需求的文本内容。

场景三:模型原型开发:AI工程师可以快速验证模型想法,进行小规模实验后再扩展到更大模型。

用户案例:该项目由AI领域知名专家Andrej Karpathy创建,已被众多研究机构和开发者用于GPT模型的学习和实验。

nanoGPT项目链接

karpathy / nanoGPT项目地址:https://github.com/karpathy/nanoGPT

本文地址:https://www.tgoos.com/16894