Modded-NanoGPT:用3分钟训练NanoGPT的极限优化方案

你是否曾经被大语言模型训练速度慢、资源消耗大所困扰?Modded-NanoGPT 的出现,旨在彻底解决这个问题。它是一个基于 PyTorch 的高度优化的语言模型训练框架,可以帮助开发者在8张H100 GPU上仅用2分20秒就完成NanoGPT(124M参数)的训练,达到3.28的验证损失。本文将带你全面了解这个训练速度的突破性项目。

截至收录:

Modded-NanoGPT stars数:3500

Modded-NanoGPT forks数:461

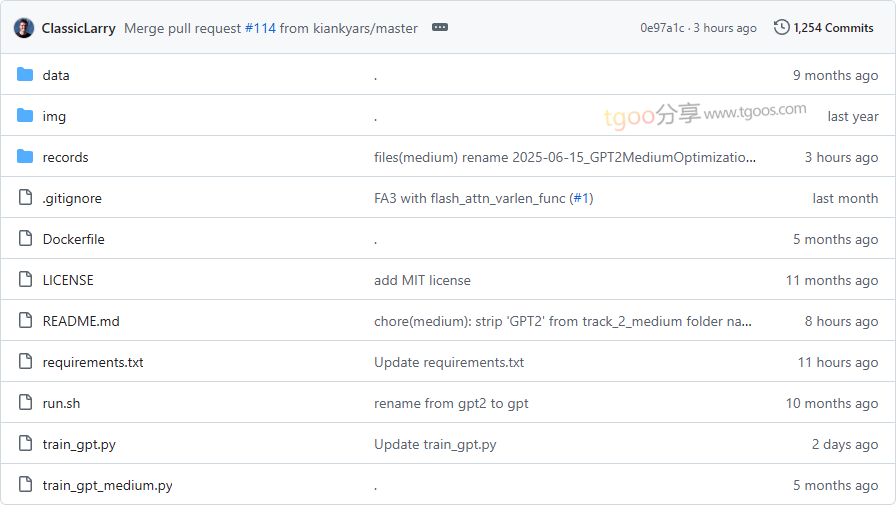

Modded-NanoGPT项目目录截图

Modded-NanoGPT核心亮点

🚀 极致训练速度:相比原始llm.c的45分钟,优化到仅需2分20秒,速度提升超过19倍。

🧠 先进模型架构:融合旋转嵌入、QK归一化、ReLU²激活函数等现代架构改进。

⚡ Muon优化器:专为高效训练设计的新型优化器,内存占用低于Adam,样本效率提升1.5倍。

🔧 系统级优化:集成Flash Attention 3、FP8矩阵乘法、梯度通信优化等多项系统优化技术。

Modded-NanoGPT快速开始

只需几步,你就能在本地运行起 Modded-NanoGPT:

- 环境准备:

git clone https://github.com/KellerJordan/modded-nanogpt.git && cd modded-nanogpt pip install -r requirements.txt pip install --pre torch --index-url https://download.pytorch.org/whl/nightly/cu126 --upgrade - 数据准备:

# 下载前900M训练token以节省时间 python data/cached_fineweb10B.py 9 - 开始训练:

./run.sh

Modded-NanoGPT应用场景

场景一:算法研究验证:研究人员可以快速验证新的训练算法和模型架构改进效果。

场景二:硬件性能测试:作为基准测试工具,评估不同GPU配置下的训练性能表现。

场景三:教育演示:为学生和开发者提供高效的模型训练演示案例。

用户案例:该项目吸引了众多研究者和工程师参与,通过社区协作不断刷新训练速度记录,展示了分布式优化和算法创新的巨大潜力。

Modded-NanoGPT链接

KellerJordan / modded-nanogpt项目地址:https://github.com/KellerJordan/modded-nanogpt

本文地址:https://www.tgoos.com/18453