LLaMA-Factory:统一高效微调100+大语言模型与视觉语言模型

你是否曾经被大语言模型微调的复杂流程所困扰?LLaMA-Factory 的出现,旨在彻底解决这个问题。它是一个基于 Python 的统一高效微调框架,可以帮助开发者轻松微调100多种主流大语言模型和视觉语言模型。本文将带你全面了解这个潜力新星。

截至收录:

LLaMA-Factory stars数:61484

LLaMA-Factory forks数:7438

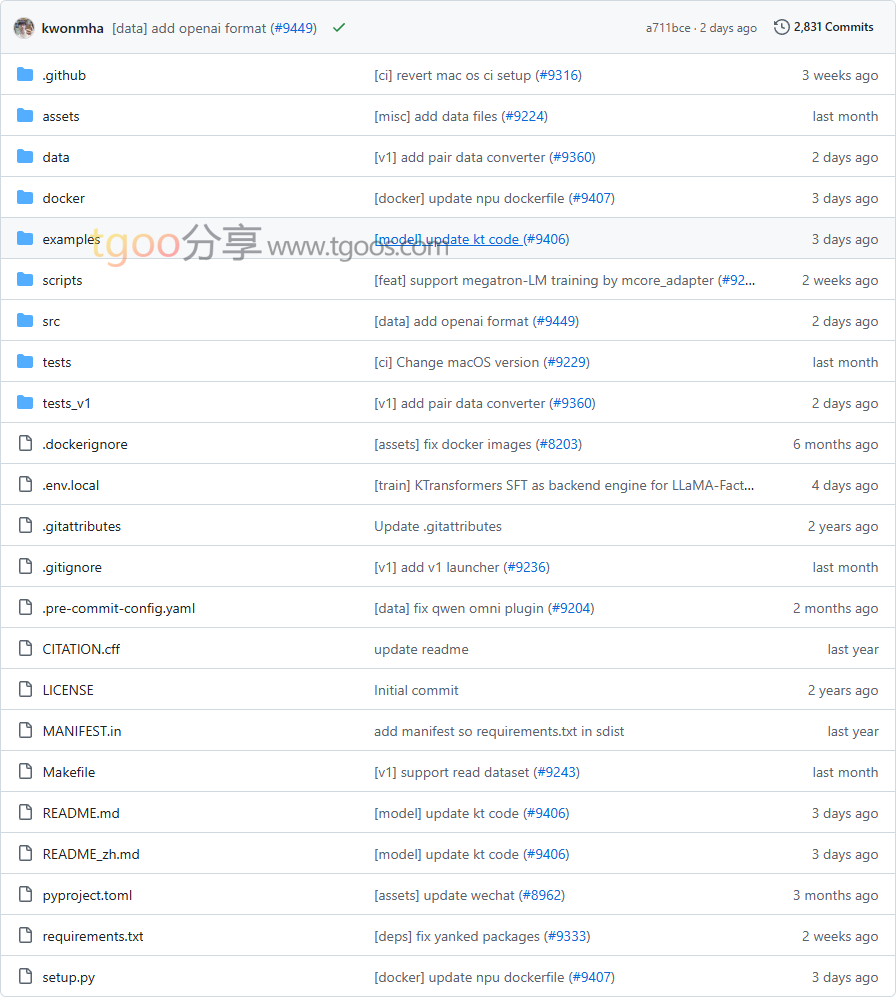

LLaMA-Factory项目目录截图

LLaMA-Factory核心亮点

🌟 模型覆盖广泛:支持 LLaMA、LLaVA、Mistral、Mixtral-MoE、Qwen、DeepSeek、Yi、Gemma、ChatGLM 等100+主流模型,涵盖文本和视觉语言模型。

🎯 训练方法全面:提供预训练、监督微调、奖励建模、PPO、DPO、KTO、ORPO 等多种训练方法,满足不同场景需求。

🔒 资源效率优化:支持16位全参数微调、冻结微调、LoRA 以及2/3/4/5/6/8位 QLoRA,大幅降低显存需求。

🧩 算法技术先进:集成 GaLore、BAdam、APOLLO、DoRA、LongLoRA、LLaMA Pro 等前沿算法,提升训练效率和模型性能。

LLaMA-Factory快速开始

只需几步,你就能在本地运行起 LLaMA-Factory:

- 安装:

# 从源码安装 git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git cd LLaMA-Factory pip install -e ".[torch,metrics]" --no-build-isolation - 运行你的第一个训练命令:

llamafactory-cli train examples/train_lora/llama3_lora_sft.yaml - 使用Web界面:

llamafactory-cli webui

LLaMA-Factory应用场景

场景一:多模态模型微调:开发者可以使用它微调视觉语言模型,实现图像理解、视觉定位、视频识别等任务。

场景二:角色扮演模型训练:通过监督微调和偏好对齐,训练出具有特定角色特征的对话模型。

场景三:领域知识适配:帮助企业将通用大模型快速适配到金融、医疗、法律等专业领域。

用户案例:目前,Amazon、NVIDIA、Aliyun 等知名公司都在使用 LLaMA-Factory 改善其AI模型开发流程。

LLaMA-Factory链接

hiyouga / LLaMA-Factory项目地址:https://github.com/hiyouga/LLaMA-Factory

本文地址:https://www.tgoos.com/22191