Native Sparse Attention:硬件对齐且原生可训练的稀疏注意力实现

你是否曾经在处理长序列Transformer模型时,被巨大的计算和内存开销所困扰?Native Sparse Attention(NSA)的出现,旨在彻底解决这个问题。它是一个基于Triton的高效稀疏注意力实现,可以帮助开发者在保持模型性能的同时显著降低计算成本。本文将带你全面了解这个潜力新星。

截至收录:

Native Sparse Attention stars数:927

Native Sparse Attention forks数:48

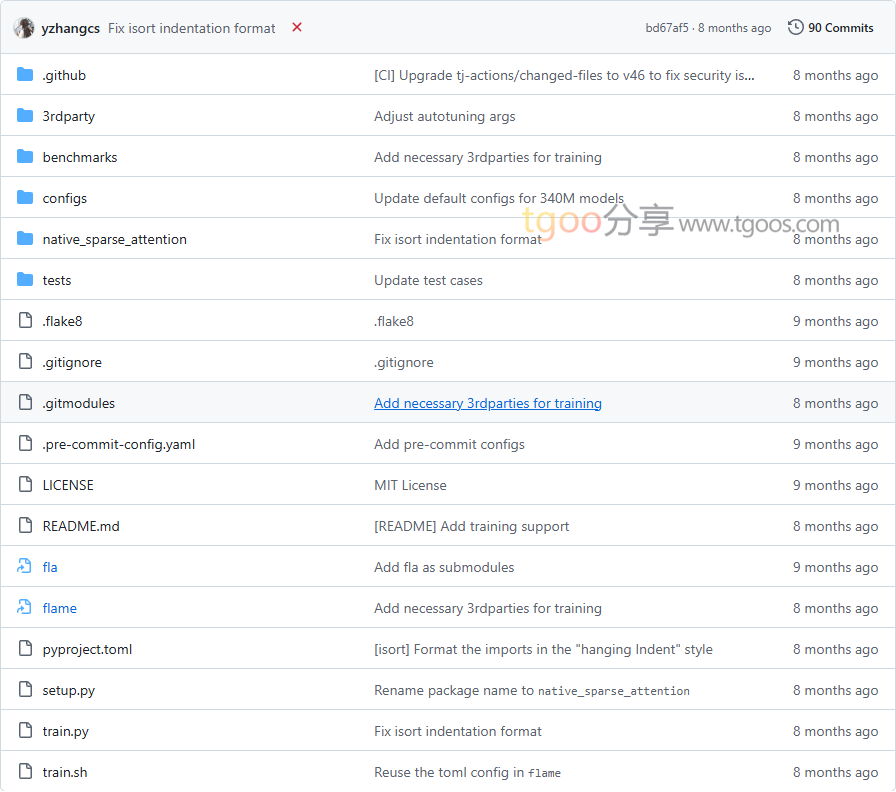

Native Sparse Attention项目目录截图

Native Sparse Attention核心亮点

🚀 极致性能:采用硬件对齐的稀疏注意力算法,通过Triton优化实现,在长序列处理上展现出卓越的计算效率。

🎯 原生可训练:支持端到端的训练过程,无需预训练或复杂的微调步骤,直接集成到现有模型中。

🔧 灵活配置:支持可变长度的输入序列和动态块选择,适应不同的模型架构和任务需求。

⚡ 最新特性:包含在线top-k选择内核、滑动注意力融合等先进功能,避免注意力矩阵的显式构建。

Native Sparse Attention快速开始

只需几步,你就能在本地运行起 Native Sparse Attention:

-

- 安装:

git clone https://github.com/fla-org/native-sparse-attention.git cd native-sparse-attention git submodule update --init --recursive pip install . - 测试正确性:

pytest tests/test_nsa.py pytest tests/test_nsa_with_compression.py - 性能基准测试:

python benchmarks/benchmark_nsa.py - 在代码中使用:

from native_sparse_attention.ops.parallel import parallel_nsa # 配置参数并调用NSA内核 parallel_nsa(q, k, v, g_slc, g_swa, block_indices, block_counts, block_size=64, window_size=64)

- 安装:

Native Sparse Attention应用场景

场景一:长序列语言建模:在处理文档级文本生成、代码补全等任务时,NSA能够有效降低长序列带来的计算负担。

场景二:多模态模型:在视觉-语言模型等需要处理长序列跨模态交互的场景中,NSA提供高效的计算方案。

场景三:实时推理应用:对于需要低延迟响应的应用,NSA的优化实现能够显著提升推理速度。

科研应用:该技术已被多个研究团队采用,用于探索更高效的大规模Transformer模型架构。

Native Sparse Attention链接

fla-org / native-sparse-attention项目地址:https://github.com/fla-org/native-sparse-attention

本文地址:https://www.tgoos.com/29083