UI-TARS-desktop:开源多模态AI智能体栈,让AI像人一样操作电脑

你是否曾幻想过,只需对电脑说一句话,AI就能帮你完成复杂的软件设置、网页浏览乃至远程操控?字节跳动开源的 UI-TARS-desktop 正是这样一个将幻想变为现实的智能体项目。它是一个基于视觉语言模型(VLM)的桌面级GUI智能体应用,能够理解你的自然语言指令,并像真人一样通过鼠标和键盘精准操控你的本地或远程计算机及浏览器。本文将带你深入了解这个正在重新定义人机交互方式的AI先锋。

截至收录:

UI-TARS-desktop项目stars数:24137

UI-TARS-desktop项目forks数:2345

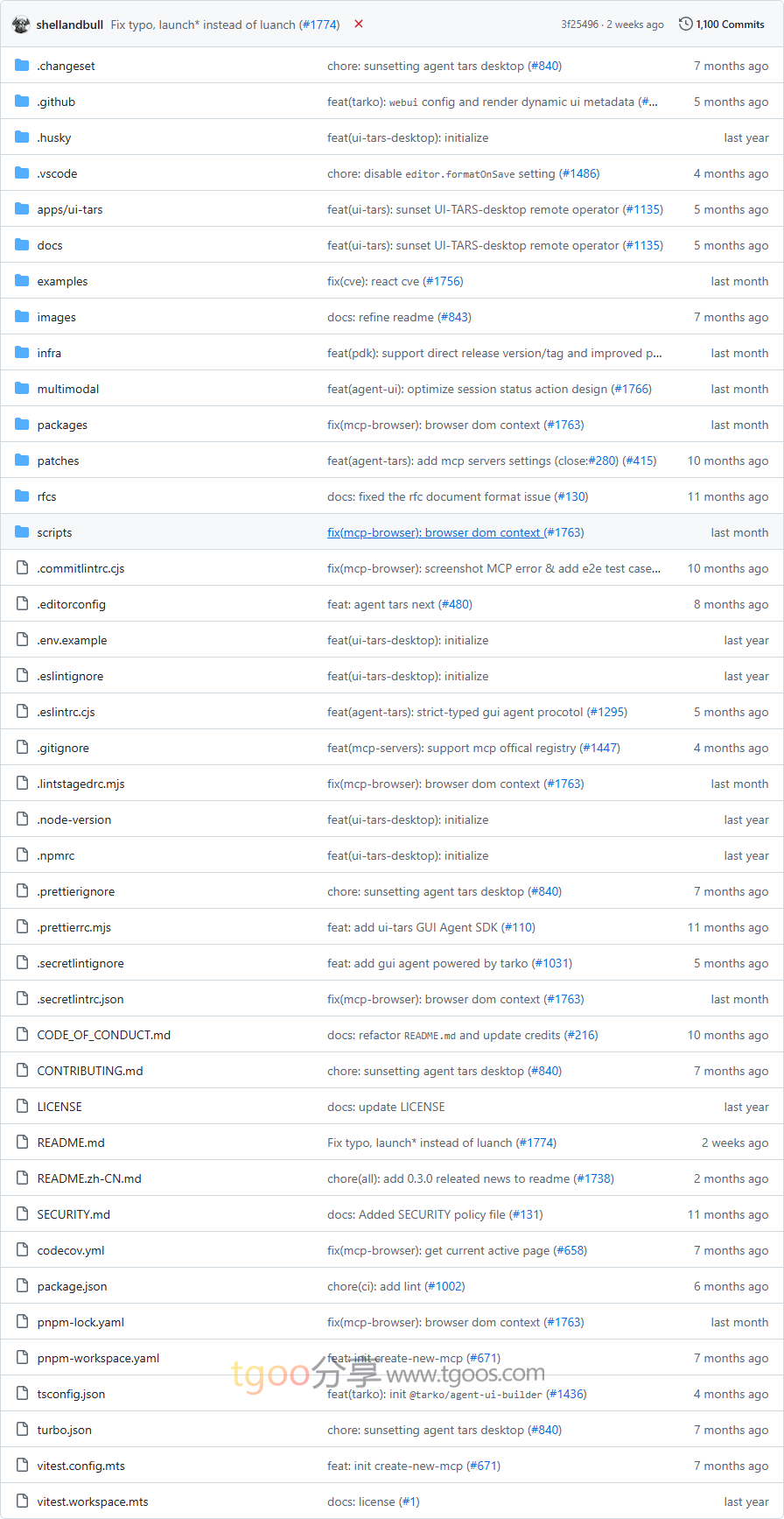

UI-TARS-desktop项目目录截图

UI-TARS-desktop项目核心亮点

- 🤖 自然语言驱动的GUI操控:核心能力。用户只需用自然语言下达指令(如“帮我打开VS Code的自动保存功能”),AI即可通过视觉识别屏幕内容,并执行精确的鼠标点击、键盘输入等操作,实现“所说即所得”。

- 🌐 本地与远程双重操作模式:独特优势。不仅支持操控本机,更提供了完全免费的远程计算机与浏览器操作功能。只需点击即可远程控制另一台设备,为跨设备协作和自动化运维打开了新大门。

- 🎯 基于顶尖多模态模型:性能基石。深度集成字节自研的UI-TARS系列及Seed-1.5-VL/1.6等先进视觉语言模型,具备强大的屏幕内容理解和推理能力,确保操作的高准确性和泛化性。

- 🔒 隐私安全与跨平台:实用保障。所有视觉识别与决策过程可在本地完成,保障数据隐私。同时提供桌面应用(Windows/macOS)和浏览器插件形式,覆盖主流使用场景。

UI-TARS-desktop项目快速开始

体验AI操控电脑的神奇,只需简单几步:

- 下载与安装:

访问项目GitHub仓库的 Release页面 下载对应操作系统(Windows/macOS)的最新版本桌面应用并安装。 - 配置模型(可选):

应用支持使用云端或本地部署的UI-TARS模型。你可以按照文档指引,配置自己的模型API密钥或使用提供的默认选项。 - 开始你的第一次AI操控:

启动应用,在输入框中用自然语言描述一个任务,例如:

> “帮我在GitHub上打开UI-TARS-desktop项目,并查看最新的issue。”点击执行,即可观看AI自动完成整个操作流程。

UI-TARS-desktop项目应用场景

- 软件自动化配置:自动化完成开发环境设置、软件偏好调整等重复性GUI操作任务,极大提升效率。

- 跨设备远程协助:无需复杂配置,即可远程帮助同事或家人操作电脑、解决问题,尤其适合IT支持和远程办公。

- 网页自动化与数据抓取:指令AI自动登录网站、填写表单、查询信息并整理结果,简化数据收集工作流。

- 无障碍辅助:为行动不便的用户提供一种全新的、通过语言指令操控电脑的交互方式,提升数字生活可及性。

UI-TARS-desktop项目链接

bytedance / UI-TARS-desktop项目地址:https://github.com/bytedance/UI-TARS-desktop

本文地址:https://www.tgoos.com/33280

声明:本站资源均整理自互联网,版权归原作者所有,仅供学习交流使用,请勿直接商用,若需商用请购买正版授权。因违规使用产生的版权及法律责任由使用者自负。部分资源可能包含水印或引流信息,请自行甄别。若链接失效可联系站长尝试补链。若侵犯您的权益,请邮件(将 # 替换为 @)至 feedback#tgoos.com,我们将及时处理删除。转载请保留原文链接,感谢支持原创。