Apache Airflow:以代码定义、调度和监控工作流的平台

你是否曾经为复杂的数据流水线编排、任务依赖管理和定时调度而头疼?Apache Airflow 的出现,旨在彻底解决这个问题。它是一个用 Python 编写的开源工作流编排平台,可以帮助开发者通过代码化(DAGs)的方式轻松构建、调度和监控复杂的数据处理流程。本文将带你全面了解这个在企业级数据工程中备受青睐的强大工具。

截至收录:

Apache Airflow stars数:42152

Apache Airflow forks数:15543

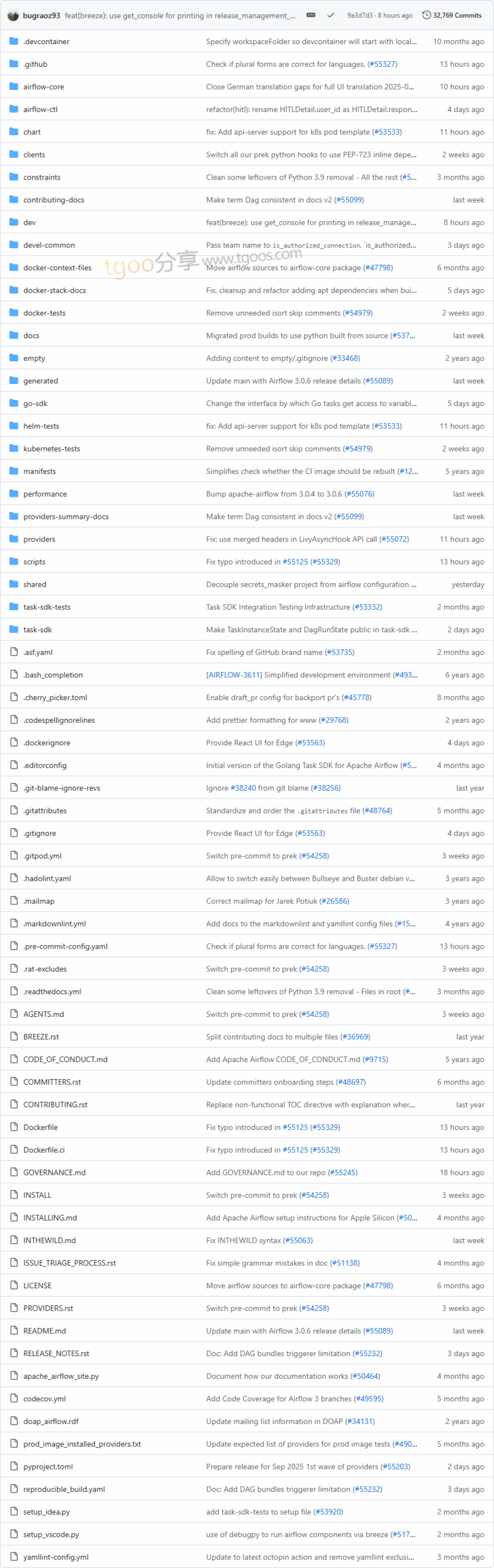

Apache Airflow项目目录截图

Apache Airflow核心亮点

- 📝 代码即流水线(DAGs):工作流以Python代码定义,支持版本控制、协作开发和自动化测试。

- 🔄 灵活可扩展的架构:提供丰富的内置Operator,并支持自定义插件,轻松对接各类外部系统(如AWS、GCP、数据库等)。

- ⏰ 强大的调度与监控能力:基于依赖关系精准调度任务,提供直观的Web UI实时监控任务执行状态与历史记录。

- 🔧 生态丰富且社区活跃:作为Apache顶级项目,拥有庞大的用户群体和持续迭代的Provider生态系统,支持多种执行环境(包括Kubernetes)。

Apache Airflow快速开始

通过以下几步,你可以快速在本地体验Airflow:

- 安装(推荐使用pip):

pip install apache-airflow==3.0.6 \ --constraint "https://raw.githubusercontent.com/apache/airflow/constraints-3.0.6/constraints-3.10.txt" - 初始化数据库并启动服务:

airflow db init airflow webserver --port 8080 airflow scheduler - 访问Web UI:

打开浏览器访问http://localhost:8080,即可开始编写和监控你的第一个DAG。

Apache Airflow应用场景

- ETL数据处理流水线:定期从多个数据源提取数据,经过清洗转换后加载到数据仓库或数据湖中。

- 机器学习流水线自动化:协调特征工程、模型训练、评估与部署等一系列任务。

- 基础设施自动化与运维任务:定期执行日志清理、备份、资源巡检等运维操作。

- 跨系统业务流程集成:作为中心调度器,协调多个微服务或API调用流程。

用户案例:Airbnb(初始开发方)、Google、Amazon、Twitter、PayPal等众多科技公司均广泛采用Airflow管理其数据流水线。

Apache Airflow链接

apache / airflow项目地址:https://github.com/apache/airflow

本文地址:https://www.tgoos.com/9382

声明:本站资源均整理自互联网,版权归原作者所有,仅供学习交流使用,请勿直接商用,若需商用请购买正版授权。因违规使用产生的版权及法律责任由使用者自负。部分资源可能包含水印或引流信息,请自行甄别。若链接失效可联系站长尝试补链。若侵犯您的权益,请邮件(将 # 替换为 @)至 feedback#tgoos.com,我们将及时处理删除。转载请保留原文链接,感谢支持原创。