garak:大型语言模型(LLM)漏洞扫描器

你是否曾担心过自己部署的大型语言模型(LLM)存在安全漏洞,可能被恶意利用导致数据泄露、误导性输出或不当内容生成?garak 的出现,正是为了解决这一痛点。它是一个由 NVIDIA 开发的开源 LLM 漏洞扫描工具,采用 Python 编写,能够全面检测 LLM 在幻觉生成、数据泄漏、提示注入、错误信息传播、毒性内容生成、越狱攻击等多个维度的潜在风险。

截至收录:

garak ⭐stars 数:5335

garak 🍴forks 数:578

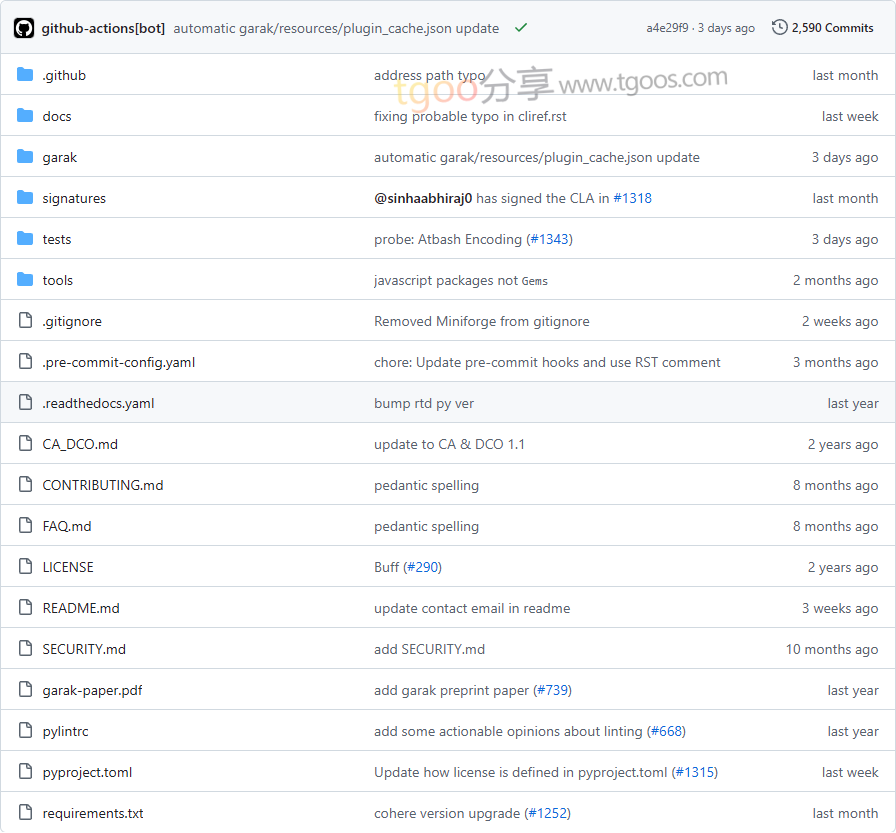

garak 项目目录截图

garak 核心亮点

- 🔍 全面漏洞探测:支持静态、动态和自适应探测方法,覆盖幻觉、数据泄漏、提示注入、越狱攻击等十多种 LLM 典型弱点。

- 🤖 多模型兼容:支持 Hugging Face、OpenAI、Replicate、Cohere、GGUF(如 llama.cpp)等多种主流 LLM 接口及私有 REST 端点。

- ⚙️ 高度可扩展:提供清晰的插件架构,用户可以轻松开发自定义探测模块(probes)、检测器(detectors)和生成器(generators)。

- 📊 清晰结果输出:实时生成进度条与详细 JSONL 日志,支持命中日志(hit log)记录,并提供分析脚本便于后续审计。

garak 快速开始

只需几步,即可开始扫描你的 LLM 模型:

- 安装 garak:

pip install -U garak - 设置环境变量(如使用 OpenAI):

export OPENAI_API_KEY="你的API密钥" - 运行扫描任务(示例:检测 ChatGPT 的编码注入漏洞):

python -m garak --model_type openai --model_name gpt-3.5-turbo --probes encoding

garak 应用场景

- 企业红队测试:安全团队可使用 garak 对内部部署的 LLM 进行自动化漏洞探测与风险评估。

- 模型开发验证:研究人员和开发者可在模型发布前通过 garak 全面检验其抗攻击能力。

- 合规与审计:适用于金融、医疗、法律等高风险行业,确保 LLM 输出符合伦理与安全标准。

用户案例:garak 已被多家科技公司和研究机构用于 LLM 安全性评估,包括 NVIDIA 内部团队及多个开源项目。

garak 项目链接

NVIDIA / garak项目地址:https://github.com/NVIDIA/garak

garak 以《星际迷航》中的角色“Elim Garak”为名,寓意“谎言是一门需要不断练习的艺术”,旨在提醒人们:唯有持续检测与改进,才能构建更安全、可信的 LLM 系统。

本文地址:https://www.tgoos.com/10336

声明:本站资源均整理自互联网,版权归原作者所有,仅供学习交流使用,请勿直接商用,若需商用请购买正版授权。因违规使用产生的版权及法律责任由使用者自负。部分资源可能包含水印或引流信息,请自行甄别。若链接失效可联系站长尝试补链。若侵犯您的权益,请邮件(将 # 替换为 @)至 feedback#tgoos.com,我们将及时处理删除。转载请保留原文链接,感谢支持原创。