DeepEval:简单易用的开源LLM评估框架

你是否曾经为评估大型语言模型(LLM)系统的输出质量而烦恼?DeepEval的出现,旨在彻底解决这个问题。它是一个基于Python的轻量级评估框架,专门为单元测试LLM输出而设计,帮助开发者快速、准确地评估和测试各种LLM应用。本文将带你全面了解这个潜力新星。

截至收录:

DeepEval项目stars数:11081

DeepEval项目forks数:955

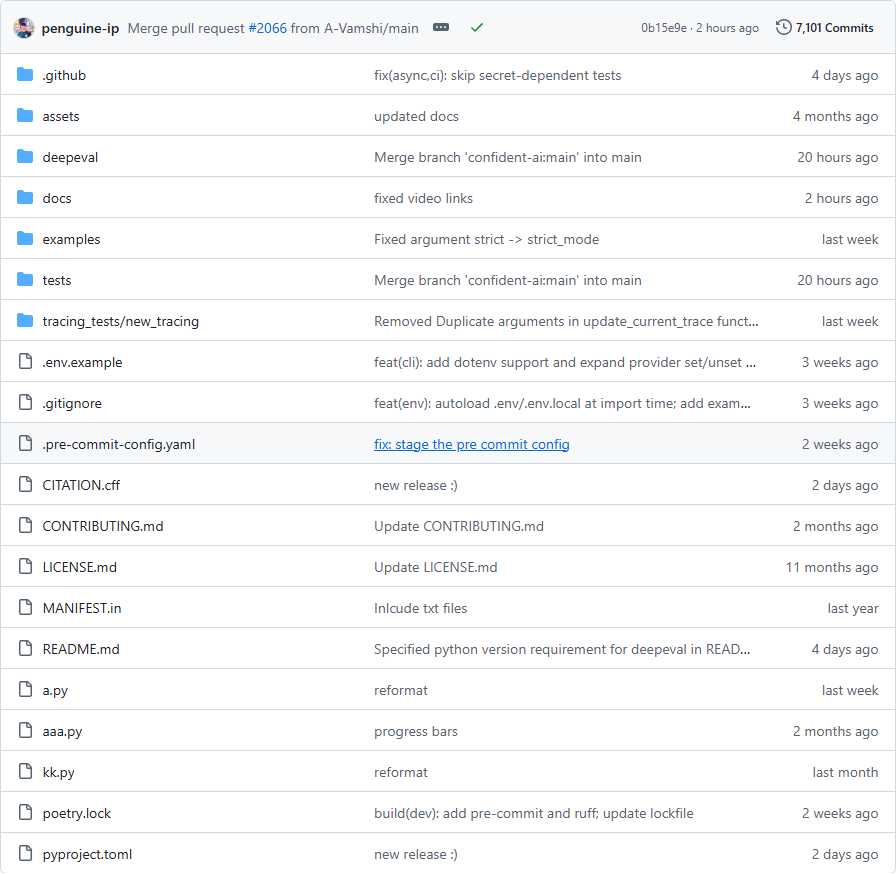

DeepEval项目目录截图

DeepEval项目核心亮点

🌟 全面的评估指标:集成最新研究,支持G-Eval、幻觉检测、答案相关性、RAGAS等数十种评估指标,使用LLM和本地NLP模型进行评估。

🎯 开箱即用:类似Pytest的简洁语法,无需复杂配置,几行代码即可开始评估LLM应用。

🔒 高度集成:完美支持LangChain、LlamaIndex等主流框架,可与任何CI/CD环境无缝集成。

🧩 灵活扩展:支持构建自定义指标,提供组件级和端到端两种评估模式,满足不同场景需求。

DeepEval项目快速开始

只需几步,你就能开始使用DeepEval评估你的LLM应用:

- 安装:

pip install -U deepeval - 创建测试文件:

import pytest from deepeval import assert_test from deepeval.metrics import GEval from deepeval.test_case import LLMTestCase, LLMTestCaseParamsdef test_case(): correctness_metric = GEval( name="Correctness", criteria="Determine if the actual output is correct based on the expected output .", evaluation_params=[LLMTestCaseParams.ACTUAL_OUTPUT, LLMTestCaseParams.EXPECTED_OUTPUT], threshold=0.5 ) test_case = LLMTestCase( input="What if these shoes don t fit?", actual_output="You have 30 days to get a full refund at no extra cost.", expected_output="We offer a 30-day full refund at no extra costs.", retrieval_context=["All customers are eligible for a 30 day full refund at no extra costs."] ) assert_test(test_case, [correctness_metric]) - 运行测试:

deepeval test run test_chatbot.py

DeepEval项目应用场景

场景一:RAG管道评估:开发者可以使用DeepEval评估检索增强生成(RAG)管道的各个组件,优化检索效果和生成质量。

场景二:AI助手测试:用于测试聊天机器人、客服助手等AI应用的回答准确性和相关性。

场景三:红队测试:对LLM应用进行40+种安全漏洞测试,包括毒性、偏见、SQL注入等。

用户案例:DeepEval已被多家企业和开源项目采用,帮助改善其LLM工作流程。

DeepEval项目链接

confident-ai / deepeval项目地址:https://github.com/confident-ai/deepeval

本文地址:https://www.tgoos.com/11713