Nano-vLLM:一个轻量级的高性能大语言模型推理引擎

你是否曾经被大语言模型推理框架的复杂性和庞大体积所困扰?Nano-vLLM 的出现,旨在彻底解决这个问题。它是一个从头构建的轻量级 vLLM 实现,可以帮助开发者在保持高性能的同时,拥有更简洁、更易理解的代码库。本文将带你全面了解这个潜力新星。

截至收录:

Nano-vLLM stars数:8180

Nano-vLLM forks数:1005

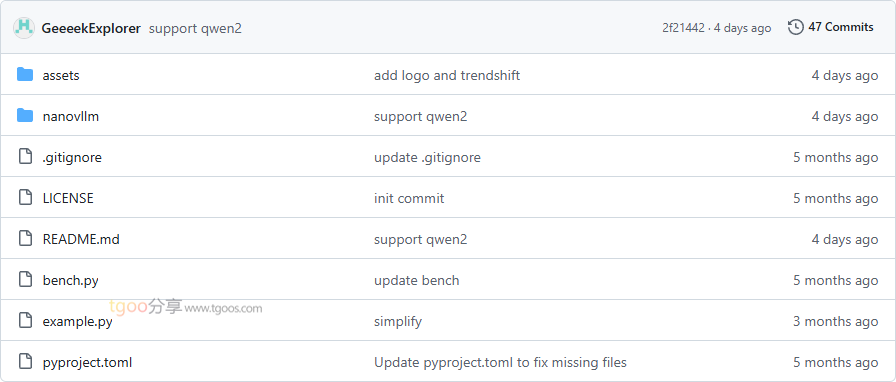

Nano-vLLM项目目录截图

Nano-vLLM核心亮点

🚀 极致性能:采用前缀缓存、张量并行、Torch编译、CUDA图等优化技术,推理速度与vLLM相当甚至更快。

📖 代码可读性:仅用约1200行Python代码实现,代码结构清晰,便于学习和定制。

⚡ 全面优化套件:集成了多种性能优化技术,包括前缀缓存、张量并行、Torch编译、CUDA图等。

🔧 易于部署:提供简单的安装方式和熟悉的API接口,快速集成到现有项目中。

Nano-vLLM快速开始

只需几步,你就能在本地运行起 Nano-vLLM:

- 安装:

pip install git+https://github.com/GeeeekExplorer/nano-vllm.git - 下载模型:

huggingface-cli download --resume-download Qwen/Qwen3-0.6B \ --local-dir ~/huggingface/Qwen3-0.6B/ \ --local-dir-use-symlinks False - 运行第一个推理:

from nanovllm import LLM, SamplingParamsllm = LLM("/YOUR/MODEL/PATH", enforce_eager=True, tensor_parallel_size=1) sampling_params = SamplingParams(temperature=0.6, max_tokens=256) prompts = ["Hello, Nano-vLLM."] outputs = llm.generate(prompts, sampling_params) print(outputs[0]["text"])

Nano-vLLM应用场景

场景一:离线推理部署:开发者可以在资源受限的环境中部署大语言模型,实现高效的离线推理服务。

场景二:研究与学习:研究人员和学生可以通过阅读简洁的代码实现,深入理解大语言模型推理的底层原理。

场景三:边缘计算:在边缘设备上运行大语言模型,为移动应用和IoT设备提供智能语言处理能力。

场景四:快速原型开发:开发者可以快速搭建和测试大语言模型应用,加速产品迭代周期。

性能表现:在RTX 4070笔记本电脑(8GB显存)上测试Qwen3-0.6B模型,Nano-vLLM在处理256个序列时,吞吐量达到1434.13 tokens/s,略优于原版vLLM的1361.84 tokens/s。

Nano-vLLM链接

GeeeekExplorer / nano-vllm项目地址:https://github.com/GeeeekExplorer/nano-vllm

本文地址:https://www.tgoos.com/22217