Verl:专为大语言模型设计的强化学习训练框架

你是否曾经在为大语言模型(LLM)实施强化学习训练时,面临算法实现复杂、框架集成困难、资源利用率低等挑战?Verl 的出现,旨在彻底解决这些问题。它是一个由字节跳动 Seed 团队发起、社区共同维护的灵活、高效且生产就绪的 RL 训练库,可以帮助开发者和研究者轻松实现从 PPO、GRPO 到 DAPO 等多种先进强化学习算法。本文将带你全面了解这个潜力新星。

截至收录:

Verl项目stars数:16094

Verl项目forks数:2593

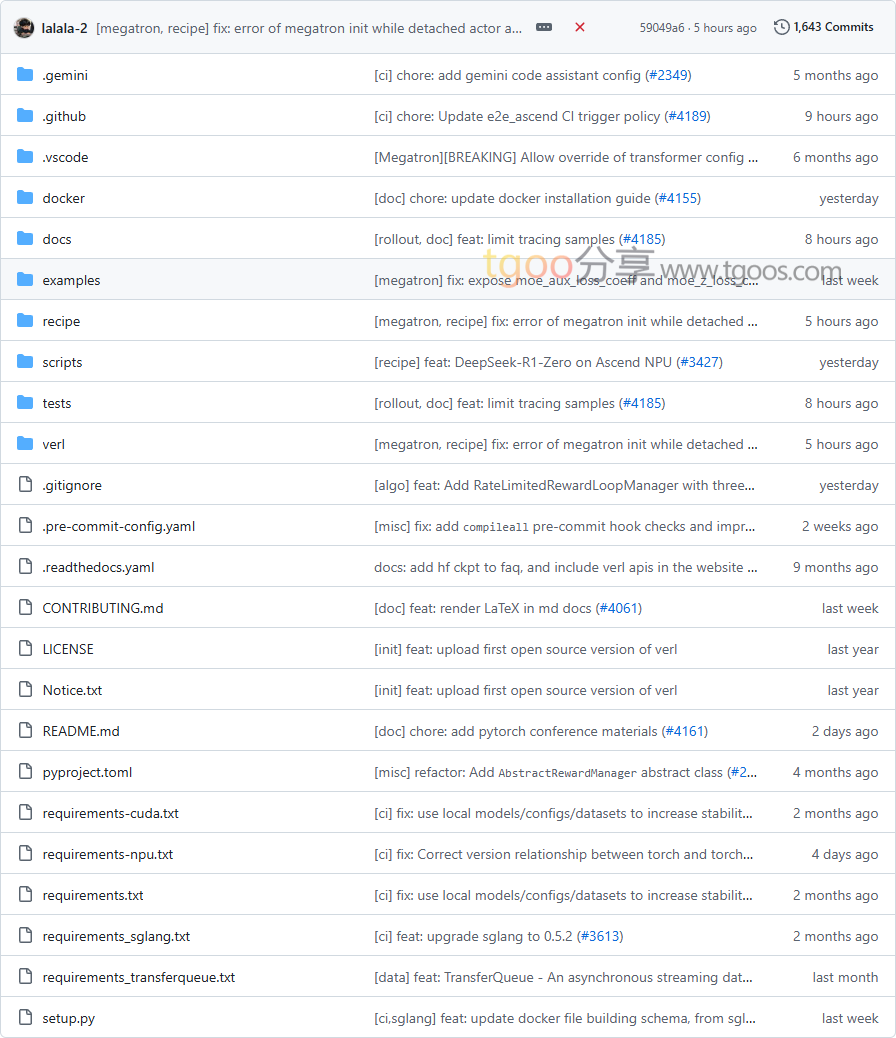

Verl项目目录截图

Verl项目核心亮点

🌟 灵活扩展的算法支持:基于混合控制器编程模型,仅需几行代码即可构建 GRPO、PPO 等复杂的数据流,支持 PPO、GRPO、GSPO、ReMax 等十余种 RL 算法。

🎯 无缝集成现有基础设施:模块化 API 设计解耦计算与数据依赖,完美兼容 FSDP、Megatron-LM、vLLM、SGLang 等主流 LLM 框架。

🔒 高效资源利用:支持灵活的 GPU 设备映射策略,通过 3D-HybridEngine 消除内存冗余,显著减少训练与生成阶段间的通信开销。

🧩 生产级性能表现:集成 SOTA 训练和推理引擎,支持 Flash Attention 2、序列打包、LoRA 等优化技术,可扩展到 671B 参数模型和数百个 GPU。

Verl项目快速开始

只需几步,你就能开始使用 Verl 进行强化学习训练:

- 安装:

# 通过 pip 安装 $ pip install verl - 运行 PPO 示例:

# 准备后训练数据 $ verl data-prepare --dataset your_dataset实现奖励函数

$ verl reward-implement --config your_config.yaml启动 PPO 训练

$ verl train --algorithm ppo --config ppo_config.yaml - 查看训练状态:

$ verl status --experiment your_experiment

Verl项目应用场景

场景一:大语言模型对齐训练:研究人员可以使用 Verl 实现 SPPO(自博弈偏好优化)等先进算法,提升模型的推理和对话能力。

场景二:多模态强化学习:支持视觉语言模型(如 Qwen2.5-VL、Kimi-VL)的 RL 训练,扩展至图像理解与生成任务。

场景三:代码与数学推理优化:通过基于模型的奖励和函数奖励机制,专门优化代码生成和数学解题能力。

用户案例:目前,字节跳动、阿里巴巴 Qwen 团队、LMSys.org、上海人工智能实验室、清华大学、UC Berkeley 等顶尖机构和团队都在使用 Verl 推进其 AI 研究。

Verl项目链接

volcengine / verl项目地址:https://github.com/volcengine/verl

本文地址:https://www.tgoos.com/24187