Memori:为LLM、AI智能体和多智能体系统提供开源记忆引擎

你是否曾经为大型语言模型缺乏持久记忆而烦恼?每次对话都要重新提供上下文,既低效又昂贵。Memori 的出现,旨在彻底解决这个问题。它是一个基于SQL的开源记忆引擎,只需一行代码就能为任何LLM提供持久化、可查询的记忆能力。本文将带你全面了解这个潜力新星。

截至收录:

Memori项目stars数:5197

Memori项目forks数:392

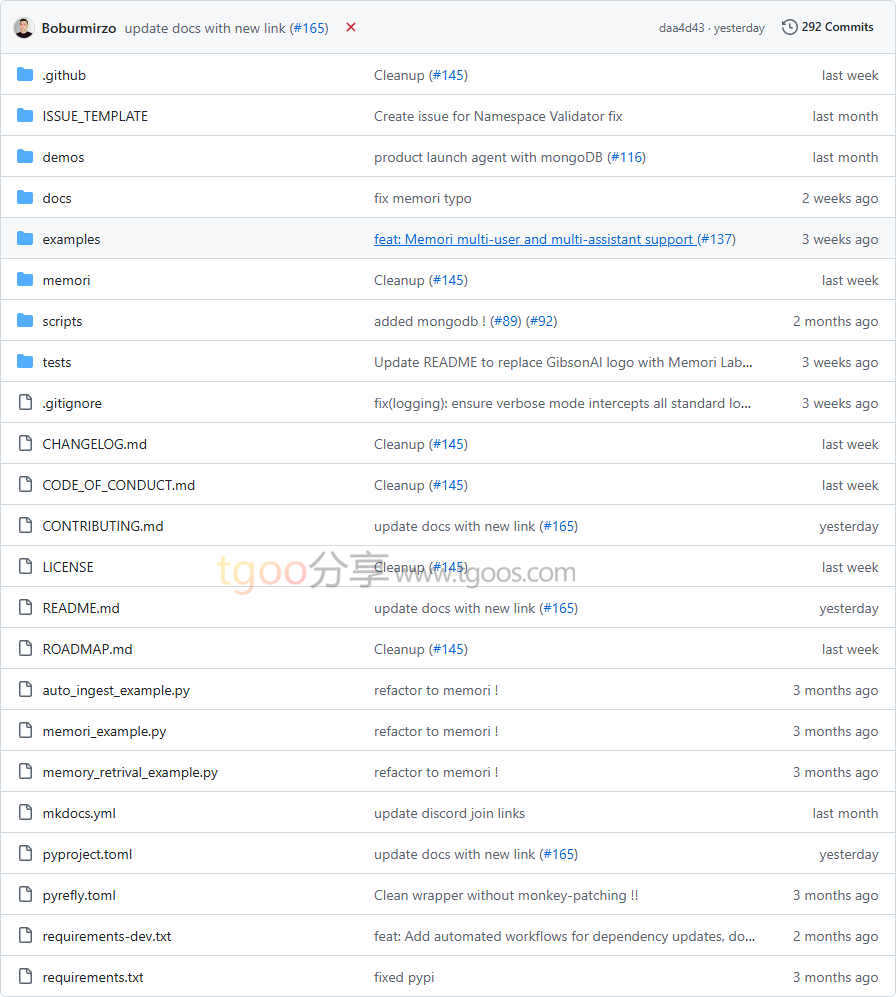

Memori项目目录截图

Memori项目核心亮点

🌟 一行代码集成:只需调用 memori.enable(),即可为任何LLM框架添加持久记忆功能。

🎯 SQL原生存储:使用标准SQL数据库(SQLite、PostgreSQL、MySQL),完全掌控数据,零供应商锁定。

💰 成本节省80-90%:无需昂贵的向量数据库,使用现有SQL基础设施即可实现智能记忆。

🧠 智能记忆管理:自动实体提取、关系映射和上下文优先级排序,让LLM真正”记住”重要信息。

Memori项目快速开始

只需几步,你就能为LLM添加持久记忆:

- 安装:

pip install memorisdk - 基础使用:

from memori import Memori from openai import OpenAI # 初始化记忆引擎 memori = Memori(conscious_ingest=True) memori.enable() client = OpenAI() # 第一次对话 - 模型会记住内容 response = client.chat.completions.create( model="gpt-4o-mini", messages=[{"role": "user", "content": "我正在构建一个FastAPI项目"}] ) # 后续对话 - Memori自动提供上下文 response = client.chat.completions.create( model="gpt-4o-mini", messages=[{"role": "user", "content": "帮我添加身份验证功能"}] ) # LLM自动知道你的FastAPI项目背景

Memori项目应用场景

场景一:个人AI助手:构建能够记住用户偏好、习惯和历史的智能助手,提供个性化服务。

场景二:多轮对话系统:客服机器人和技术支持系统能够记住整个对话历史,提供连贯的服务体验。

场景三:多智能体协作:在AutoGen、CrewAI等多智能体系统中,实现智能体间的记忆共享和上下文传递。

场景四:企业知识管理:将企业文档、会议记录等结构化存储,供LLM在需要时智能检索和使用。

用户案例:目前,Memori已集成到AgentOps、Agno、AWS Strands、Azure AI Foundry、AutoGen、CamelAI、CrewAI等主流AI框架和平台中。

Memori项目链接

GibsonAI / Memori项目地址:https://github.com/GibsonAI/Memori

本文地址:https://www.tgoos.com/24065