MuseV:基于视觉条件并行去噪的无限长度高保真虚拟人视频生成框架

你是否曾为生成高质量、长序列且动作自然的虚拟人视频而烦恼?MuseV 的出现,旨在彻底解决这个问题。它是一个基于扩散模型的虚拟人视频生成框架,通过创新的视觉条件并行去噪方案,支持生成无限长度的视频。本文将带你全面了解这个来自腾讯音乐娱乐集团(TME)音视频实验室(Lyra Lab)的潜力新星。

截至收录:

MuseV项目stars数:2812

MuseV项目forks数:301

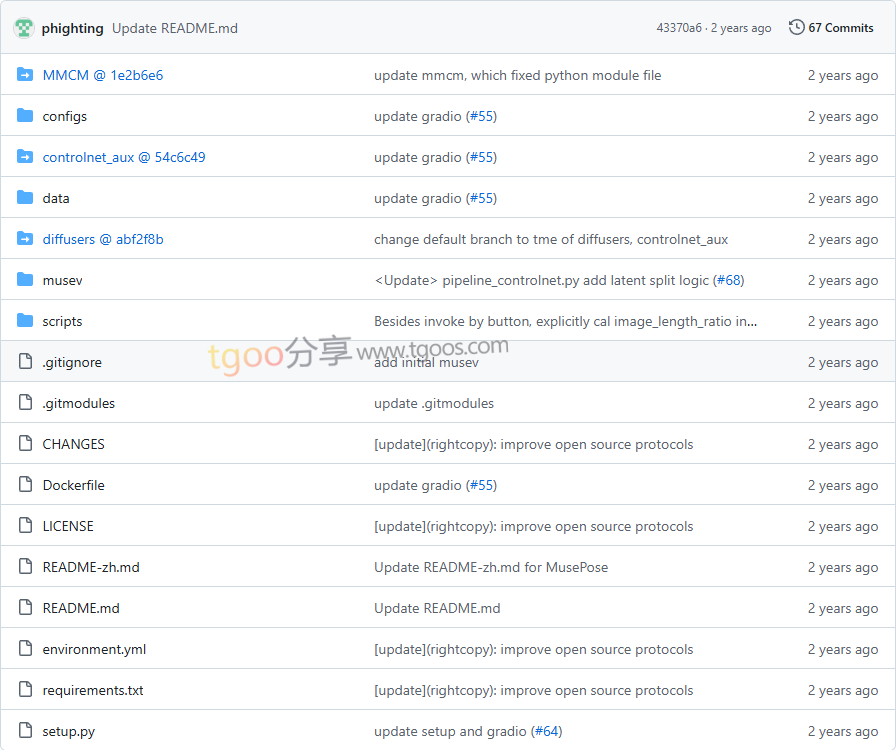

MuseV项目目录截图

MuseV项目核心亮点

- 🌟 无限长度生成:通过创新的“视觉条件并行去噪”方案,有效解决了长视频生成中的累积误差问题,理论上支持生成无限长度的视频。

- 🎯 功能全面强大:支持文生视频、图生视频、视频生视频等多种生成模式,并兼容 Stable Diffusion 生态,可灵活使用各类基础模型、LoRA、ControlNet等。

- 🧩 多参考图像技术:集成了 IP-Adapter、ReferenceOnly、ReferenceNet、IP-Adapter-FaceID 等多种先进技术,能更好地保持角色一致性、面部特征和姿态。

- 🔧 完整的虚拟人解决方案:与同团队开源的实时高质量口型同步模型 MuseTalk、姿态控制图像生视频框架 MusePose 相结合,构成了从静态形象到动态交互的端到端虚拟人生成方案。

MuseV项目快速开始

你可以通过 Docker 快速搭建 MuseV 的运行环境:

1. 拉取并运行 Docker 镜像:

docker pull anchorxia/musev:latest

docker run --gpus all -it --entrypoint /bin/bash anchorxia/musev:latest2. 克隆项目并下载模型:

git clone --recursive https://github.com/TMElyralab/MuseV.git

cd MuseV

git clone https://huggingface.co/TMElyralab/MuseV ./checkpoints3. 运行你的第一个文生视频示例:

python scripts/inference/text2video.py \

--sd_model_name majicmixRealv6Fp16 \

--unet_model_name musev_referencenet \

--test_data_path ./configs/tasks/example.yaml \

--target_datas yongen \

--output_dir ./outputMuseV项目应用场景

- 虚拟偶像与内容创作:为虚拟主播、数字人偶像生成高质量、多样化的舞蹈、表演或日常互动视频,大幅降低内容制作成本。

- 游戏与影视预演:快速生成游戏角色的动作片段或影视作品的动态分镜,用于前期创意验证和流程规划。

- 个性化视频生成:结合用户提供的单张照片或简短描述,生成具有特定外观、姿态和场景的个性化短视频。

- 教育与培训:创建虚拟教师或培训师的讲解视频,使教学内容更加生动和吸引人。

用户案例:目前,MuseV 及其关联项目(MuseTalk, MusePose)已形成一个完整的虚拟人生成技术栈,吸引了众多开发者和研究机构进行探索与应用,在虚拟人驱动、AI视频生成社区中获得了广泛关注。

MuseV项目链接

TMElyralab / MuseV项目地址:https://github.com/TMElyralab/MuseV

本文地址:https://www.tgoos.com/32576

声明:本站资源均整理自互联网,版权归原作者所有,仅供学习交流使用,请勿直接商用,若需商用请购买正版授权。因违规使用产生的版权及法律责任由使用者自负。部分资源可能包含水印或引流信息,请自行甄别。若链接失效可联系站长尝试补链。若侵犯您的权益,请邮件(将 # 替换为 @)至 feedback#tgoos.com,我们将及时处理删除。转载请保留原文链接,感谢支持原创。