Scraperr:无需代码的自托管网页抓取利器

你是否曾为获取网站数据而不得不编写复杂的爬虫脚本?Scraperr 的出现,旨在彻底解决这个问题。它是一个强大的自托管网页抓取解决方案,允许开发者和数据分析师无需编写一行代码,即可轻松提取、管理和导出网页数据。本文将带你全面了解这个高效的数据采集工具。

截至收录:

Scraperr项目stars数:4808

Scraperr项目forks数:236

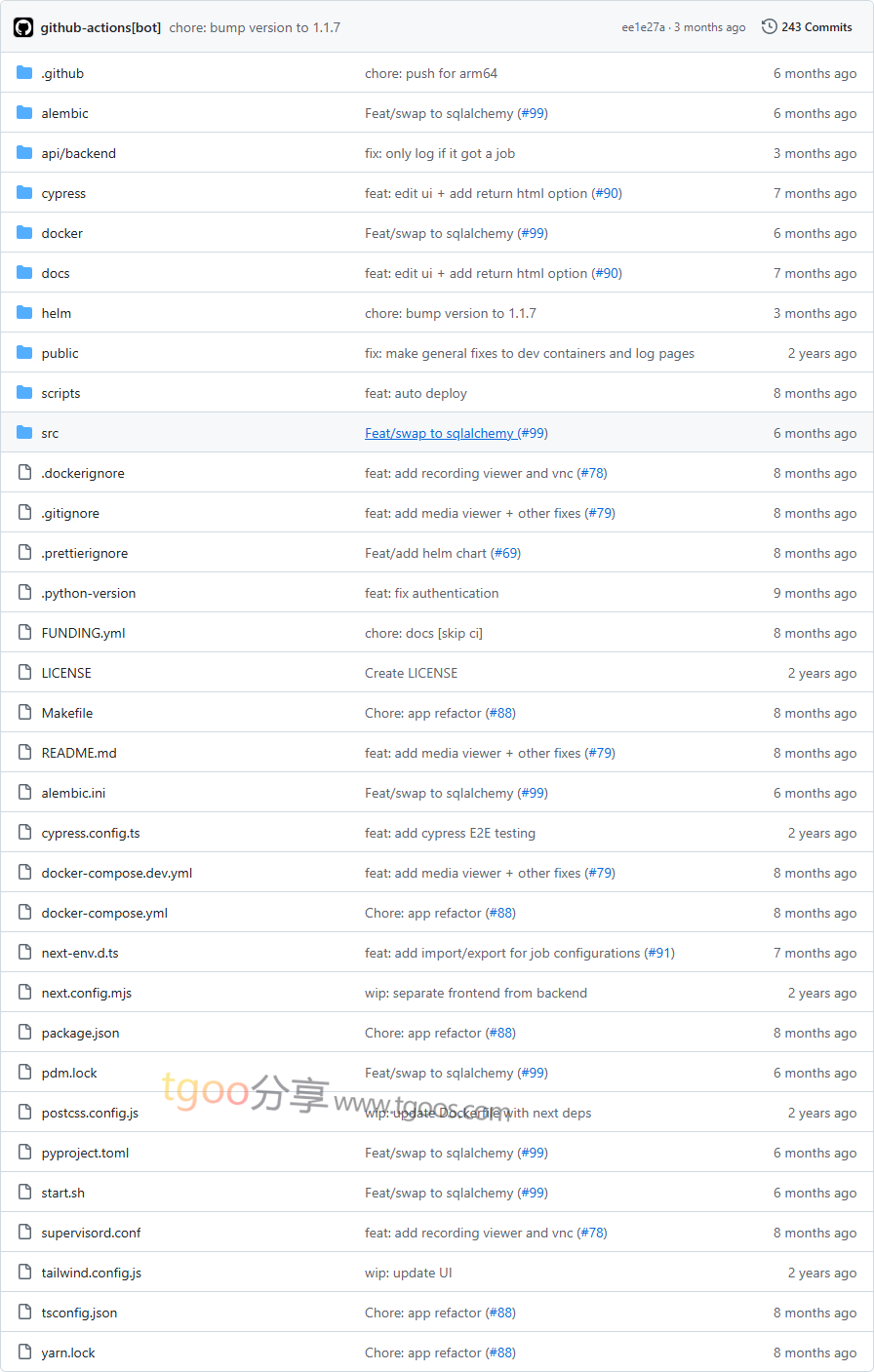

Scraperr项目目录截图

Scraperr项目核心亮点

🌟 XPath精准提取:支持使用XPath语法精确地定位和提取页面中的特定元素,确保数据抓取的准确性。

🎯 队列与任务管理:提供强大的队列管理功能,可以提交、管理和监控多个抓取任务,实现批量自动化操作。

🕸️ 域名爬虫模式:除了单页抓取,还支持爬取同一域名下的所有页面,适合需要全面采集的场景。

📊 数据可视化与导出:抓取结果可以在结构化的表格中清晰查看,并支持一键导出为Markdown或CSV格式,方便后续分析。

Scraperr项目快速开始

只需几步,你就能在本地运行起 Scraperr:

1. 使用Docker启动(推荐):

# 克隆项目后,使用make命令快速启动

$ git clone https://github.com/jaypyles/Scraperr.git

$ cd Scraperr

$ make up2. 访问Web界面:

启动后,在浏览器中访问 http://localhost:3000(具体端口请参考文档)即可使用图形化界面配置抓取任务。

3. 使用Helm部署(Kubernetes):

对于生产环境,可以参考官方文档使用Helm Chart在Kubernetes集群中进行部署。

Scraperr项目应用场景

场景一:市场研究与竞品分析:市场人员可以定期抓取竞争对手的产品信息、价格和用户评论,自动生成分析报告。

场景二:内容聚合与监控:开发者可以搭建内容聚合平台,自动从多个新闻或博客网站抓取最新文章,实现信息流整合。

场景三:学术数据收集:研究人员可以无需编程,轻松从学术网站或公开数据库抓取结构化数据用于统计分析。

用户案例:作为一个新兴但功能强大的自托管方案,Scraperr 正被越来越多的个人开发者和团队用于替代复杂的脚本编写,简化数据采集工作流。

Scraperr项目链接

jaypyles / Scraperr项目地址:https://github.com/jaypyles/Scraperr

本文地址:https://www.tgoos.com/33990