Daft:用Python和SQL轻松处理大规模多模态数据的分布式查询引擎

你是否曾经为处理海量、多模态数据(如图片、URL、张量等)而头疼?Daft的出现,旨在彻底解决这个问题。它是一个用Rust实现的高性能分布式查询引擎,可以帮助数据工程师、科学家和开发者以Python或SQL的方式,简单高效地处理任何规模和类型的数据。本文将带你全面了解这个潜力新星。

截至收录:

Daft项目stars数:3999

Daft项目forks数:282

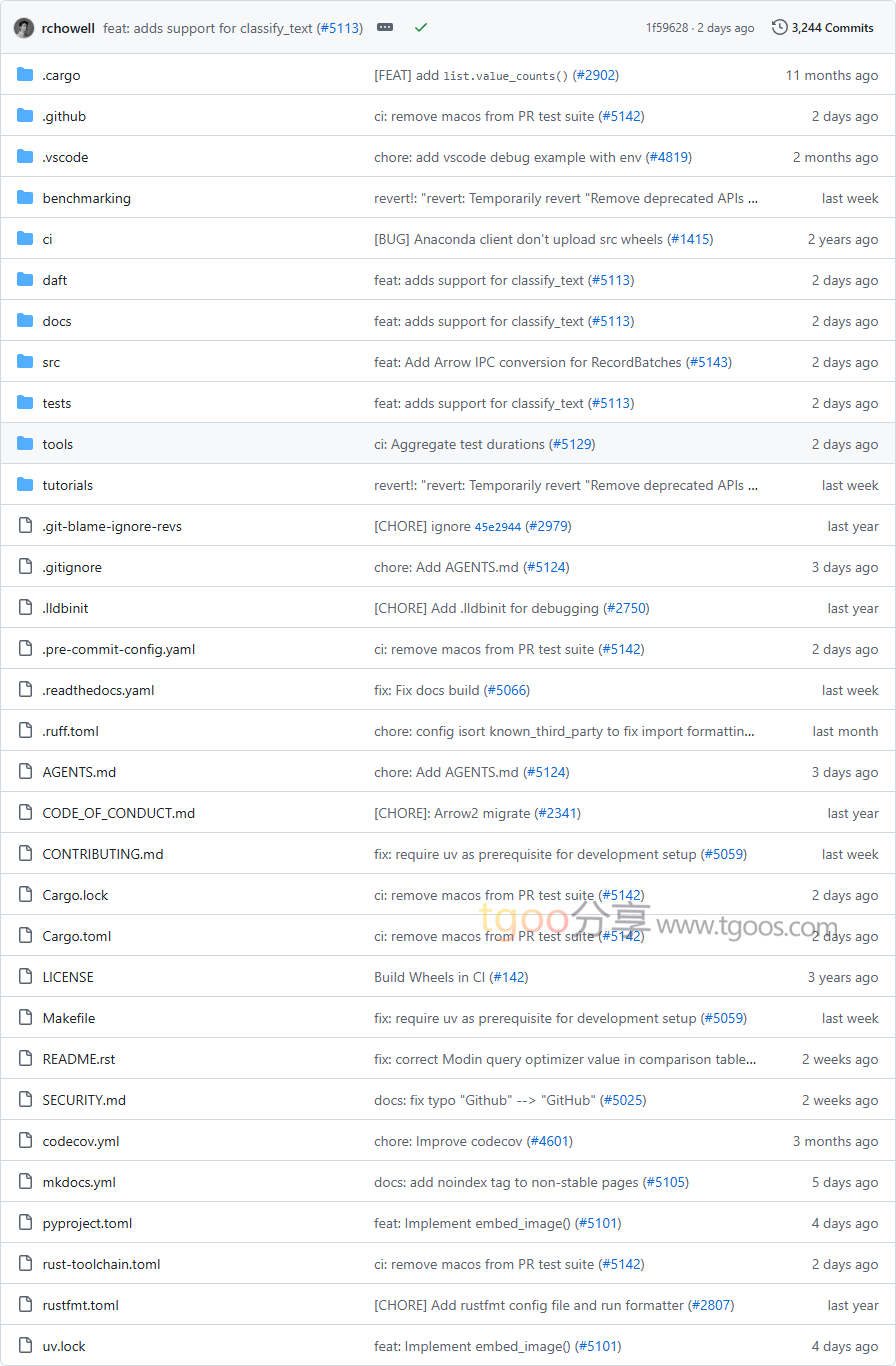

Daft项目目录截图

Daft项目核心亮点

🌟 多模态数据处理:超越传统的字符串/数字/日期类型,原生支持图像、嵌入向量、Python对象等复杂数据类型,基于Apache Arrow内存格式实现高效存储和计算。

🎯 智能查询优化:内置强大的查询优化器,能够自动重写查询计划,让数据操作达到最佳性能,用户只需关注”要做什么”而非”如何做”。

🔒 云端原生设计:为云存储优化,在S3等对象存储上实现破纪录的I/O性能,轻松处理PB级数据。

🧩 分布式计算能力:原生集成Ray框架,支持在数千个CPU/GPU的大型集群上运行,轻松扩展计算能力。

Daft项目快速开始

只需几步,你就能开始使用Daft处理多模态数据:

- 安装:

$ pip install daft

- 运行你的第一个多模态数据处理:

import daft # 从S3加载图像数据 df = daft.from_glob_path("s3://daft-public-data/laion-sample-images/*") # 下载并解码图像,然后调整尺寸 df = df.with_column("image", df["path"].url.download().image.decode()) df = df.with_column("resized", df["image"].image.resize(32, 32)) df.show(3)

Daft项目应用场景

场景一:多模态AI数据处理:机器学习工程师可以轻松处理包含图像、文本和数值特征的复杂数据集,为模型训练准备高质量输入。

场景二:大规模数据ETL:数据工程师可以使用熟悉的Python API或SQL进行分布式ETL处理,无需学习复杂的分布式系统细节。

场景三:交互式数据探索:数据科学家在Jupyter笔记本中快速迭代和探索大规模数据集,智能缓存和优化加速实验过程。

用户案例:Daft的设计理念和强大功能使其成为处理现代多模态数据工作负载的理想选择,特别适合需要处理图像、嵌入向量等复杂数据类型的AI和数据分析场景。

Daft项目链接

Eventual-Inc / Daft项目地址:https://github.com/Eventual-Inc/Daft

本文地址:https://www.tgoos.com/9134