Pathway LLM-App:一站式企业级实时AI应用部署模板

你是否曾经为构建和部署基于大语言模型(LLM)的RAG应用、AI流水线或企业搜索系统而头疼?Pathway LLM-App 提供了一系列开箱即用的云模板,帮助你快速搭建高精度、可扩展的AI应用,并实时同步企业数据源,让AI应用始终基于最新知识运行。

截至收录:

Pathway LLM-App stars数:35831

Pathway LLM-App forks数:963

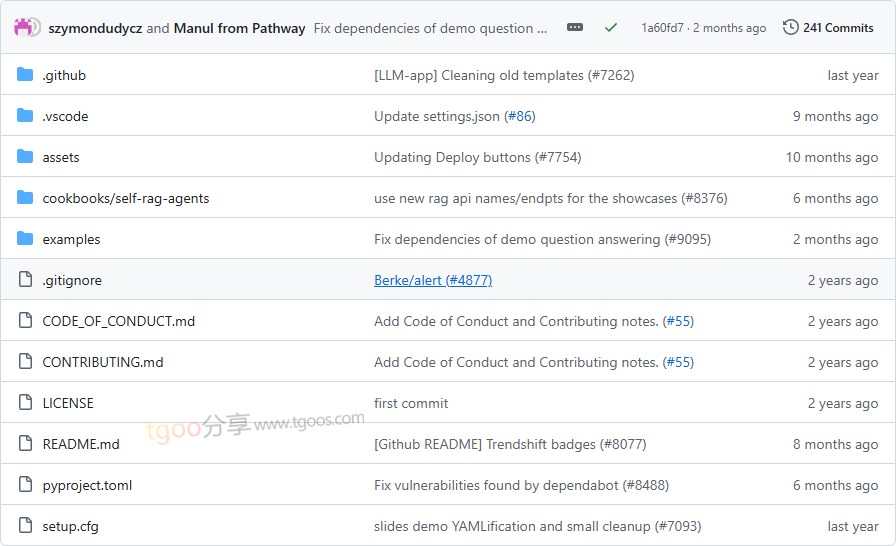

Pathway LLM-App项目目录截图

Pathway LLM-App核心亮点

🌟 实时数据同步:无缝连接并实时同步文件系统、Google Drive、SharePoint、S3、Kafka、PostgreSQL及实时数据API,支持数据的增删改查操作。

🎯 开箱即用:提供多种预构建应用模板(如RAG问答、多模态索引、非结构化转SQL等),无需额外配置基础设施,一键部署至云端或本地。

🔒 高性能检索:内置向量搜索、混合搜索和全文检索功能,基于usearch和Tantivy库实现内存级高速缓存,支持百万级文档处理。

🐳 Docker友好:所有应用均以Docker容器形式提供,轻松集成到现有DevOps流程,并支持REST API与Streamlit前端演示。

Pathway LLM-App快速开始

只需几步,即可在本地运行一个RAG问答应用:

1. 克隆项目并进入模板目录:

git clone https://github.com/pathwaycom/llm-app

cd llm-app/question-answering2. 配置环境并启动服务(以Docker为例):

docker-compose up --build3. 通过API或Streamlit UI测试功能:

curl -X POST http://localhost:8000/query -H "Content-Type: application/json" -d {"query":"你的问题"}Pathway LLM-App应用场景

场景一:企业级实时问答系统

整合内部文档(如PDF、DOCX),通过RAG技术提供精准答案,适用于客服、内部知识库等场景。

场景二:多模态数据索引与检索

使用GPT-4o解析财务报告中的图表和表格,实时更新索引,支持金融、审计等领域的动态数据分析。

场景三:私有化部署AI应用

通过Mistral和Ollama实现完全本地的RAG流水线,满足数据安全和合规需求。

用户案例:目前已有企业利用该模板在Google Drive、SharePoint等平台构建实时文档检索与告警系统。

Pathway LLM-App链接

通过Pathway LLM-App,开发者可以快速构建和部署高性能AI应用,无需从零搭建复杂的数据同步、索引和检索基础设施。无论是初创公司还是大型企业,都能从中获得高效、可扩展的AI解决方案。

pathwaycom / llm-app项目地址:https://github.com/pathwaycom/llm-app

本文地址:https://www.tgoos.com/9377