LLMs-from-scratch:从零开始构建类ChatGPT大语言模型

你是否曾经对大语言模型(LLM)的内部工作原理感到好奇,却苦于没有合适的入门途径?LLMs-from-scratch 的出现,旨在彻底解决这个问题。它是一个基于 PyTorch 的逐步实现指南,可以帮助开发者从零开始理解、预训练和微调一个类似 GPT 的大语言模型。本文将带你全面了解这个潜力新星。

截至收录:

LLMs-from-scratch stars数:71287

LLMs-from-scratch forks数:10251

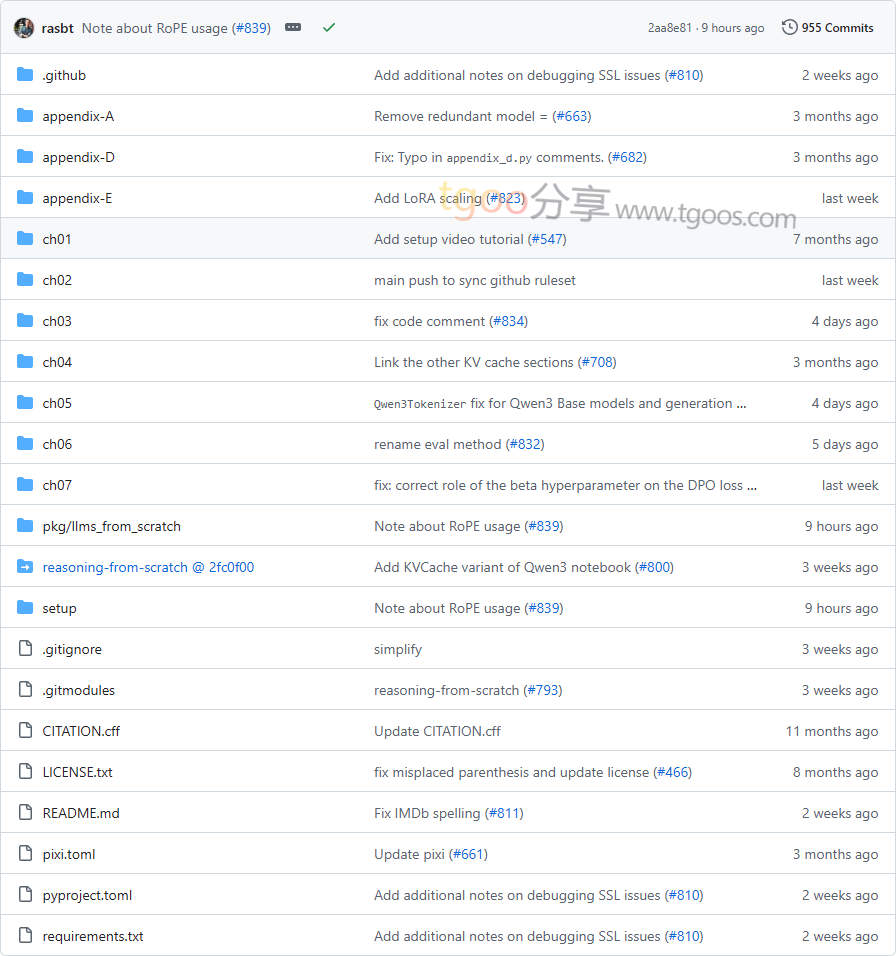

LLMs-from-scratch项目目录截图

LLMs-from-scratch核心亮点

🌟 从零实现的完整流程:项目提供了从数据预处理、注意力机制编码、GPT模型构建到预训练和微调的完整实现,每一步都有详细解释和代码示例。

🎯 教育与实用并重:不仅适合教育目的,还包含加载更大预训练模型进行微调的代码,帮助读者理解工业级模型的构建方法。

🔒 低硬件门槛:代码设计为可在常规笔记本电脑上运行,无需专业硬件,同时支持GPU加速以提高效率。

🧩 丰富的扩展内容:包含大量额外材料,如字节对编码(BPE)分词器实现、KV缓存、LoRA参数高效微调等高级主题。

LLMs-from-scratch快速开始

只需几步,你就能开始探索大语言模型的构建过程:

- 克隆仓库:

git clone --depth 1 https://github.com/rasbt/LLMs-from-scratch.git - 设置环境:

建议查看setup目录下的 README.md 文件,获取Python环境和依赖包安装指南。 - 运行示例代码:

# 例如运行第2章文本数据处理示例 jupyter notebook ch02/ch02.ipynb

LLMs-from-scratch应用场景

场景一:深度学习教育:非常适合作为大学课程或自学材料,通过动手实践深入理解Transformer架构和LLM工作原理。

场景二:研究原型开发:研究人员可以基于此代码库快速构建和实验自己的模型变体,如修改注意力机制或尝试新的训练策略。

场景三:工业实践入门:为希望进入LLM领域的工程师提供扎实的基础,理解从预训练到指令微调的完整流程。

用户案例:该项目是《Build a Large Language Model (From Scratch)》一书的官方代码库,已被全球数千名学习者和研究者使用。

LLMs-from-scratch链接

rasbt / LLMs-from-scratch项目地址:https://github.com/rasbt/LLMs-from-scratch

本文地址:https://www.tgoos.com/10512