LocalAI:开源免费的本地AI推理平台

你是否曾经为依赖云端AI服务的高昂费用、隐私泄露风险或网络延迟而烦恼?LocalAI 的出现,旨在彻底解决这个问题。它是一个完全开源、本地优先的AI推理平台,可以作为OpenAI、Claude等商业AI服务的直接替代品,帮助开发者在消费级硬件上运行各种AI模型,无需GPU即可享受强大的AI能力。本文将带你全面了解这个潜力新星。

截至收录:

LocalAI项目stars数:37733

LocalAI项目forks数:2975

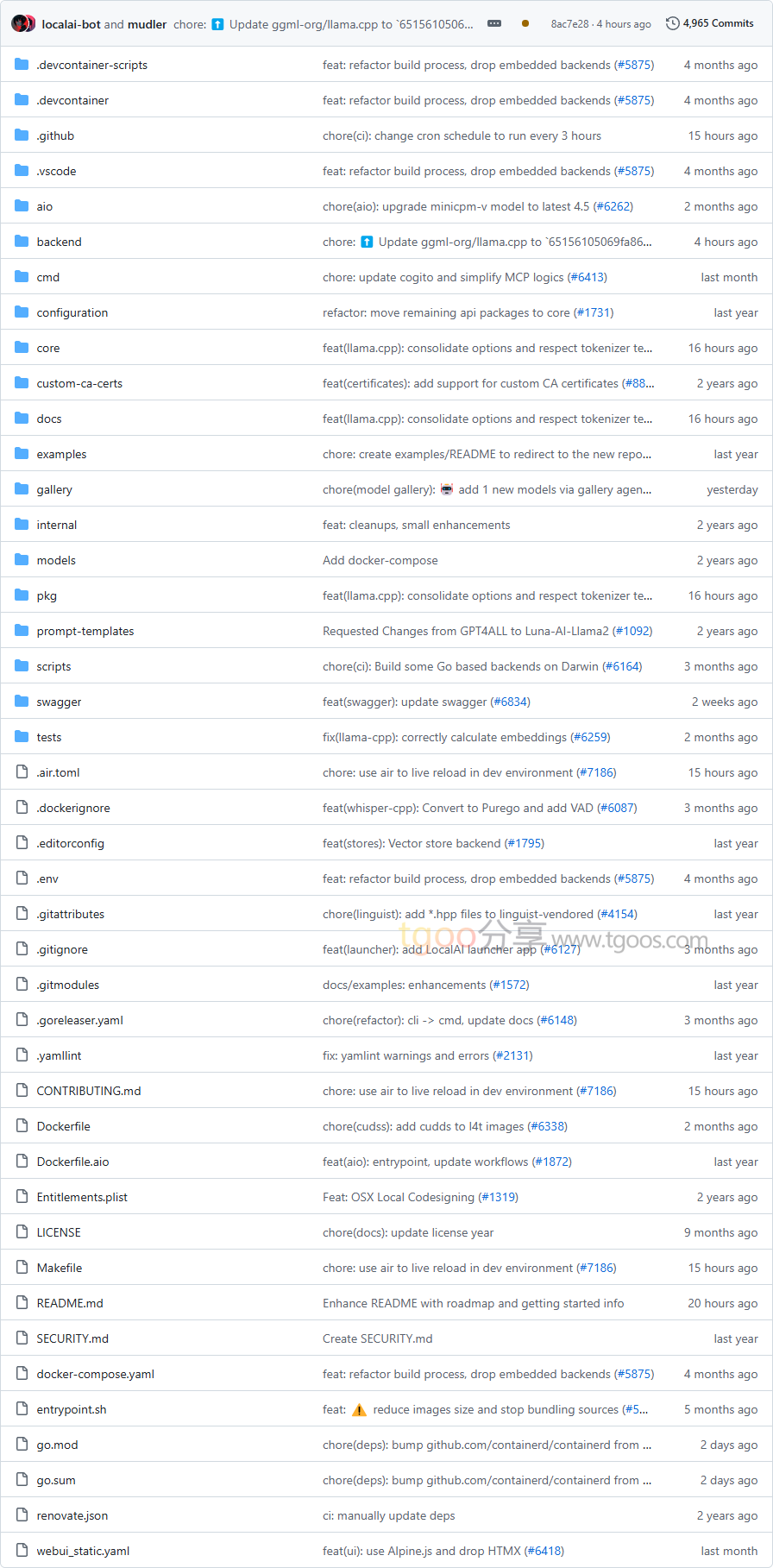

LocalAI项目目录截图

LocalAI项目核心亮点

🌟 完全开源免费:作为OpenAI、Claude等商业服务的开源替代品,LocalAI消除了使用AI服务的成本壁垒,让每个人都能免费享受先进的AI技术。

🎯 开箱即用:提供与OpenAI API完全兼容的REST API接口,现有应用无需修改代码即可无缝迁移到本地部署的AI服务。

🔒 隐私安全优先:采用本地优先架构,所有数据和模型都在本地运行,彻底杜绝数据泄露风险,满足企业级安全要求。

🧩 多模态AI支持:支持文本生成、图像生成、音频处理、语音克隆、视频生成、目标检测等十多种AI能力,覆盖绝大多数AI应用场景。

LocalAI项目快速开始

只需几步,你就能在本地运行起 LocalAI:

- 安装:

# 使用安装脚本 $ curl https://localai.io/install.sh | sh - 使用Docker运行:

# CPU版本 $ docker run -ti --name local-ai -p 8080:8080 localai/localai:latestNVIDIA GPU版本

$ docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12 - 运行第一个模型:

# 从模型库运行模型 $ local-ai run llama-3.2-1b-instruct:q4_k_m # 直接从HuggingFace运行模型 $ local-ai run huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf

LocalAI项目应用场景

场景一:企业私有AI部署:企业可以在内部服务器上部署LocalAI,为员工提供AI助手服务,同时确保商业数据完全不外泄。

场景二:个人开发者AI应用:独立开发者可以使用LocalAI构建各种AI应用,如智能聊天机器人、图像生成工具、语音助手等,无需支付昂贵的API费用。

场景三:边缘计算AI推理:在资源受限的边缘设备上部署轻量级AI模型,实现本地化的智能决策和处理。

用户案例:目前,该项目已被众多开发者和组织用于构建各种AI应用,包括智能客服、文档处理、代码助手等多个场景。

LocalAI项目链接

mudler / LocalAI项目地址:https://github.com/mudler/LocalAI

本文地址:https://www.tgoos.com/22541