GGML:专为机器学习优化的高性能张量库

你是否在机器学习项目中遇到过内存占用过高、推理速度慢或跨平台部署困难的问题?GGML 正是为解决这些痛点而生。它是一个用 C++ 编写的高效张量计算库,专注于为机器学习模型提供轻量级、低延迟的推理支持。无论是边缘设备还是高性能服务器,GGML 都能帮助开发者实现资源优化的模型部署。本文将带你深入了解这一备受关注的开源项目。

截至收录:

GGML项目stars数:13503

GGML项目forks数:1385

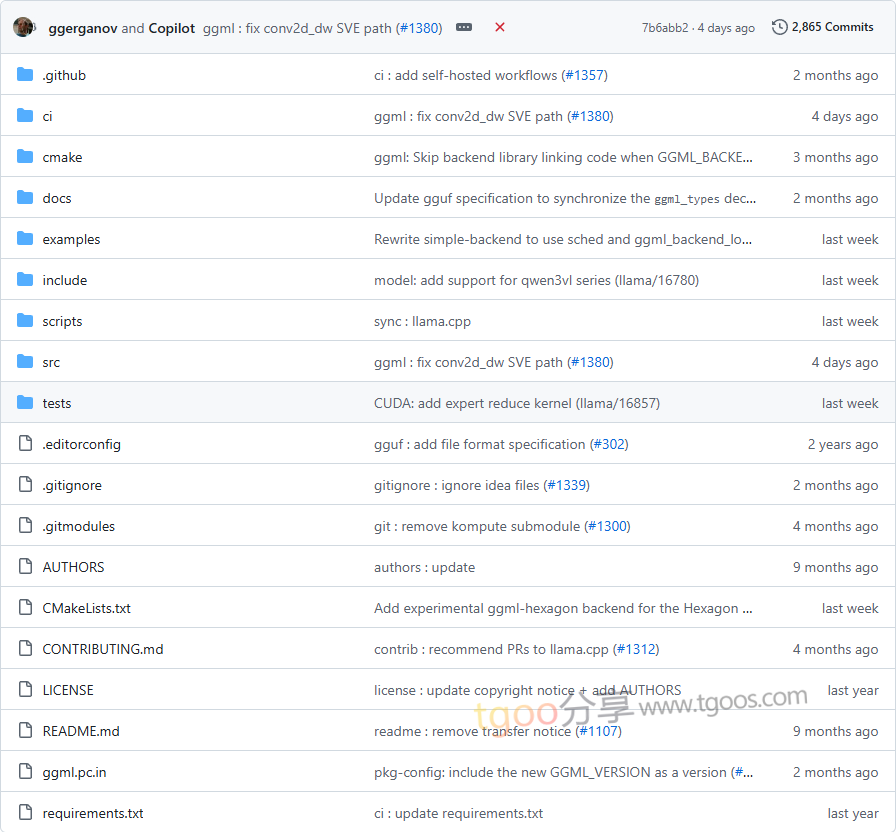

GGML项目目录截图

GGML项目核心亮点

- 🚀 极致性能与低内存占用:支持整数量化技术,显著降低模型体积与内存需求,运行时实现零动态内存分配。

- 🌐 广泛的硬件兼容性:原生支持 CPU、CUDA、HIP(AMD GPU)及 SYCL(Intel GPU),并可编译部署至 Android 等移动端平台。

- 🔧 内置优化与自动微分:集成 ADAM、L-BFGS 等优化器,并支持自动微分,简化模型训练与调优流程。

- 📦 无第三方依赖:完全独立的 C++ 实现,避免复杂的依赖链,保障跨平台部署的稳定性与可移植性。

GGML项目快速开始

通过以下步骤快速体验 GGML 的 GPT 模型推理能力:

克隆并构建项目:

git clone https://github.com/ggml-org/ggml

cd ggml

mkdir build && cd build

cmake ..

cmake --build . --config Release -j 8下载并运行示例模型:

# 下载 GPT-2 小模型(117M 参数)

../examples/gpt-2/download-ggml-model.sh 117M

# 启动推理测试

./bin/gpt-2-backend -m models/gpt-2-117M/ggml-model.bin -p "Hello, GGML!"GGML项目应用场景

- 边缘设备推理:通过整数量化与低内存设计,在资源受限的 IoT 或移动设备上高效运行模型。

- 跨平台模型部署:借助 CUDA、HIP 和 SYCL 后端,无缝适配 NVIDIA、AMD 及 Intel 的硬件生态。

- 轻量级训练与优化:结合内置优化器,支持小规模模型的端到端训练与微调。

- 移动端 AI 集成:通过 Android NDK 编译,将模型嵌入移动应用,实现本地化智能功能。

GGML项目链接

ggml-org / ggml项目地址:https://github.com/ggml-org/ggml

本文地址:https://www.tgoos.com/22859

声明:本站资源均整理自互联网,版权归原作者所有,仅供学习交流使用,请勿直接商用,若需商用请购买正版授权。因违规使用产生的版权及法律责任由使用者自负。部分资源可能包含水印或引流信息,请自行甄别。若链接失效可联系站长尝试补链。若侵犯您的权益,请邮件(将 # 替换为 @)至 feedback#tgoos.com,我们将及时处理删除。转载请保留原文链接,感谢支持原创。