Wan2.1:开源先进的视频生成模型套件

你是否曾经为生成高质量视频内容而烦恼?Wan2.1的出现,旨在彻底解决这个问题。它是一个开源的大规模视频生成模型套件,可以帮助开发者和创作者轻松实现文本到视频、图像到视频、视频编辑等多种生成任务。本文将带你全面了解这个潜力新星。

截至收录:

Wan2.1项目stars数:14790

Wan2.1项目forks数:2173

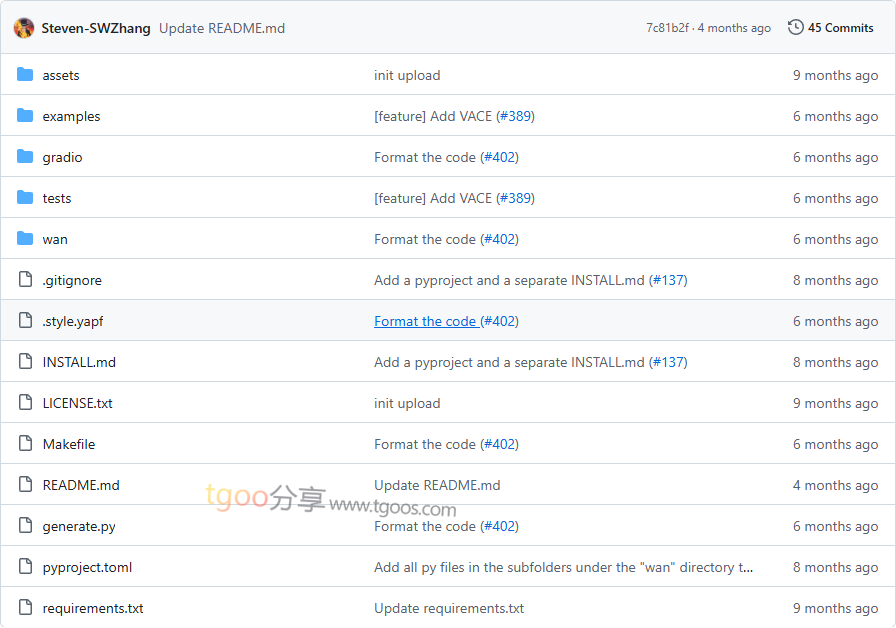

Wan2.1项目目录截图

Wan2.1项目核心亮点

🌟 极致性能:在多个基准测试中持续超越现有开源模型和商业解决方案,达到业界领先水平。

🎯 消费级GPU友好:T2V-1.3B模型仅需8.19GB显存,兼容几乎所有消费级GPU,在RTX 4090上约4分钟即可生成5秒480P视频。

🔒 多任务支持:支持文本到视频、图像到视频、视频编辑、文本到图像、视频到音频等多种生成任务。

🧩 视觉文本生成:首个支持中英文文本生成的视频模型,具备强大的文本生成能力,增强实际应用价值。

💎 强大视频VAE:Wan-VAE能够编码和解码任意长度的1080P视频,同时保持时间信息,为视频和图像生成提供理想基础。

Wan2.1项目快速开始

只需几步,你就能在本地运行起Wan2.1:

- 安装:

# 克隆仓库 git clone https://github.com/Wan-Video/Wan2.1.git cd Wan2.1 # 安装依赖(确保torch >= 2.4.0) pip install -r requirements.txt - 下载模型:

# 使用HuggingFace下载 pip install "huggingface_hub[cli]" huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B - 运行文本到视频生成:

python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt "两只拟人化的猫穿着舒适的拳击装备和明亮的手套,在聚光灯照射的舞台上激烈地打斗。"

Wan2.1项目应用场景

场景一:创意内容制作:创作者可以使用文本描述快速生成高质量视频内容,大幅提升创作效率。

场景二:视频编辑和增强:基于现有图像或视频进行扩展生成,实现视频风格转换、内容编辑等功能。

场景三:教育和演示:教师和演示者可以快速生成教学视频,直观展示复杂概念和过程。

用户案例:目前,基于Wan2.1的多个衍生项目如EchoShot、AniCrafter、HyperMotion、MagicTryOn等都在使用该模型改善其视频生成工作流。

Wan2.1项目链接

Wan-Video / Wan2.1项目地址:https://github.com/Wan-Video/Wan2.1

本文地址:https://www.tgoos.com/29234