DragGAN:通过拖拽点实现生成图像的精准编辑

你是否曾经希望像捏泥巴一样,通过简单的拖拽就能精准编辑一张图片中物体的姿态、形状或表情?DragGAN 的出现,让这一切成为可能。它是一个基于 StyleGAN3 的交互式图像编辑工具,允许用户仅需设置几个控制点,就能在生成图像流形上实现直观、精准的编辑。本文将带你深入了解这一 SIGGRAPH 2023 的明星项目。

截至收录:

DragGAN项目stars数:35994

DragGAN项目forks数:3448

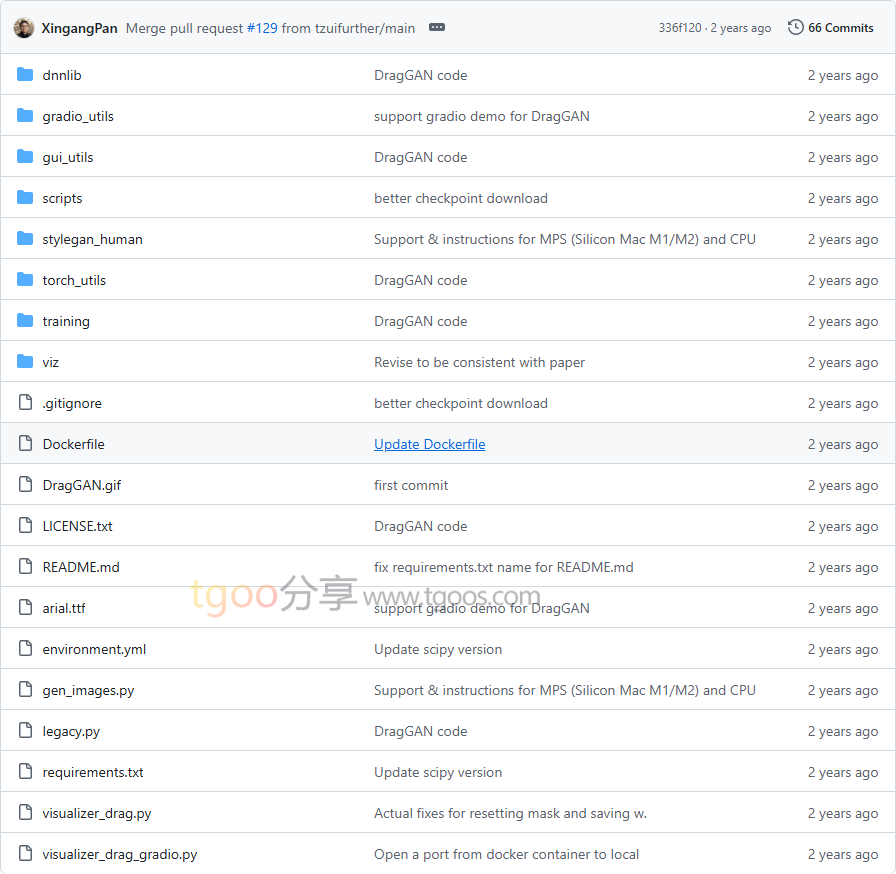

DragGAN项目目录截图

DragGAN项目核心亮点

🎯 点控式精准编辑:只需设置起始点和目标点,就能精确控制图像中物体的位置、姿态和形状

🤖 基于生成模型:建立在 StyleGAN3 之上,确保编辑后的图像保持高质量和真实感

🌐 多平台支持:提供 Gradio Web 界面、本地 GUI 和 Docker 容器化部署,满足不同使用场景

📚 模型兼容性强:支持多种预训练模型,包括 StyleGAN-Human 和 Landscapes HQ 等专业数据集

DragGAN项目快速开始

只需简单几步,即可体验 DragGAN 的强大功能:

- 环境配置:

conda env create -f environment.yml conda activate stylegan3 pip install -r requirements.txt - 下载预训练模型:

python scripts/download_model.py - 启动图形界面:

# Linux/Mac sh scripts/gui.sh # Windows .\scripts\gui.bat # 或使用 Gradio 演示 python visualizer_drag_gradio.py

DragGAN项目应用场景

💡 创意设计与艺术创作:设计师和艺术家可以快速调整图像构图,尝试不同的视觉表达方案

🔬 学术研究与教育:研究人员可用其演示生成模型的编辑能力,学生可直观理解 GAN 的工作原理

📷 照片后期处理:虽然需要先进行 GAN 反演,但能实现传统修图软件难以做到的复杂形变编辑

🎮 游戏与动画制作:快速生成角色不同姿态的变体,为游戏和动画制作提供素材

DragGAN项目链接

XingangPan / DragGAN项目地址:https://github.com/XingangPan/DragGAN

本文地址:https://www.tgoos.com/30148