Bert-VITS2-ext:让语音合成同步生成面部表情的开源工具

你是否曾经在为虚拟角色制作语音时,为如何同步生成自然的面部表情而烦恼?Bert-VITS2-ext 的出现,完美解决了这个难题。它是一个基于 Bert-VITS2 的扩展项目,不仅能够生成高质量的语音,还能同步输出对应的面部表情数据,为数字人创作带来全新可能。本文将带你深入了解这个创新项目。

截至收录:

Bert-VITS2-ext stars数:536

Bert-VITS2-ext forks数:59

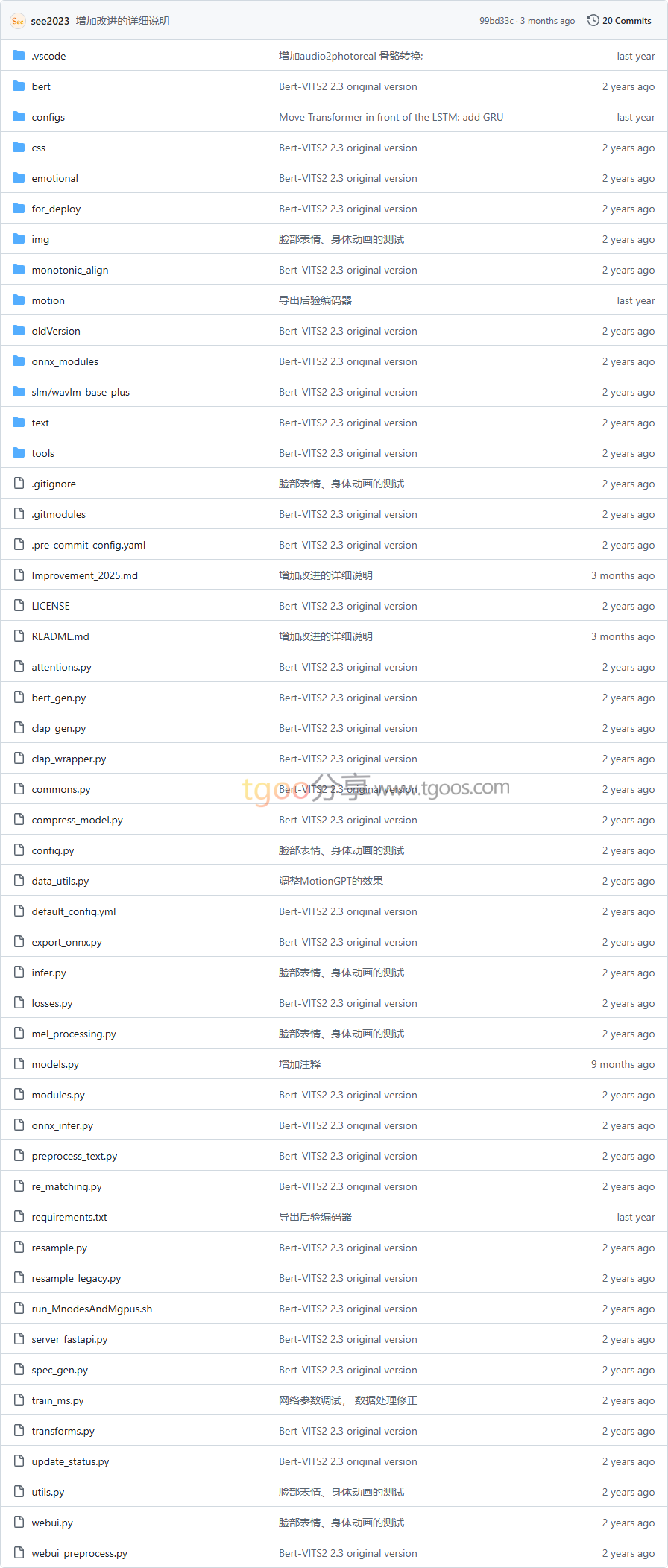

Bert-VITS2-ext项目目录截图

Bert-VITS2-ext核心亮点

🎭 语音表情同步生成:在生成语音的同时,自动输出对应的 Live Link Face 表情数据,实现音画完美同步。

🚀 2025年架构升级:输入从1D升级为2D,用Conv2D替代Conv1D,移除计算量巨大的Transformer模块,大幅提升效率。

🔄 多模型兼容扩展:已成功扩展到 CosyVoice 和 GPT-SoVITS 等主流TTS模型,展现出色的适配能力。

🎯 即插即用设计:通过旁路LSTM和MLP处理,冻结原网络参数,实现表情生成功能的无缝集成。

Bert-VITS2-ext快速开始

想要体验语音表情同步生成的魅力?只需几个简单步骤:

- 环境准备:

# 克隆项目 git clone https://github.com/see2023/Bert-VITS2-ext.git cd Bert-VITS2-ext - 数据采集:

# 设置Live Link Face Targets为本机IP,端口11111 # 执行采集脚本,每次20秒 python ./motion/record.py - 训练模型:

# 使用--visemes参数开启表情训练 python train_ms.py -m OUTPUT_MODEL --config ./configs/config.json --visemes

Bert-VITS2-ext应用场景

虚拟数字人制作:为MetaHuman等数字人角色提供语音和表情的同步生成,大幅提升制作效率。

游戏角色配音:游戏开发中快速生成NPC的语音和对应表情动画,丰富游戏体验。

在线教育助手:为虚拟教师生成自然的讲课语音和表情,提升教学互动性。

影视动画预演:在动画制作前期快速生成角色配音和基本表情,用于故事板验证。

技术拓展:项目还支持与MotionGPT结合,在生成语音表情的基础上,进一步生成匹配的身体动画,实现完整的虚拟角色表演。

Bert-VITS2-ext链接

see2023 / Bert-VITS2-ext项目地址:https://github.com/see2023/Bert-VITS2-ext

本文地址:https://www.tgoos.com/31158