Ollama:在本地轻松运行大型语言模型

你是否曾经想体验最新的大型语言模型,却苦于复杂的部署流程、高昂的云端成本或数据隐私的担忧?Ollama 的出现,旨在彻底解决这个问题。它是一个开源的、跨平台的框架,可以帮助开发者和研究者在个人电脑上轻松下载、运行和管理各种开源大语言模型(LLM)。本文将带你全面了解这个让本地AI触手可及的热门工具。

截至收录:

Ollama项目stars数:159705

Ollama项目forks数:14179

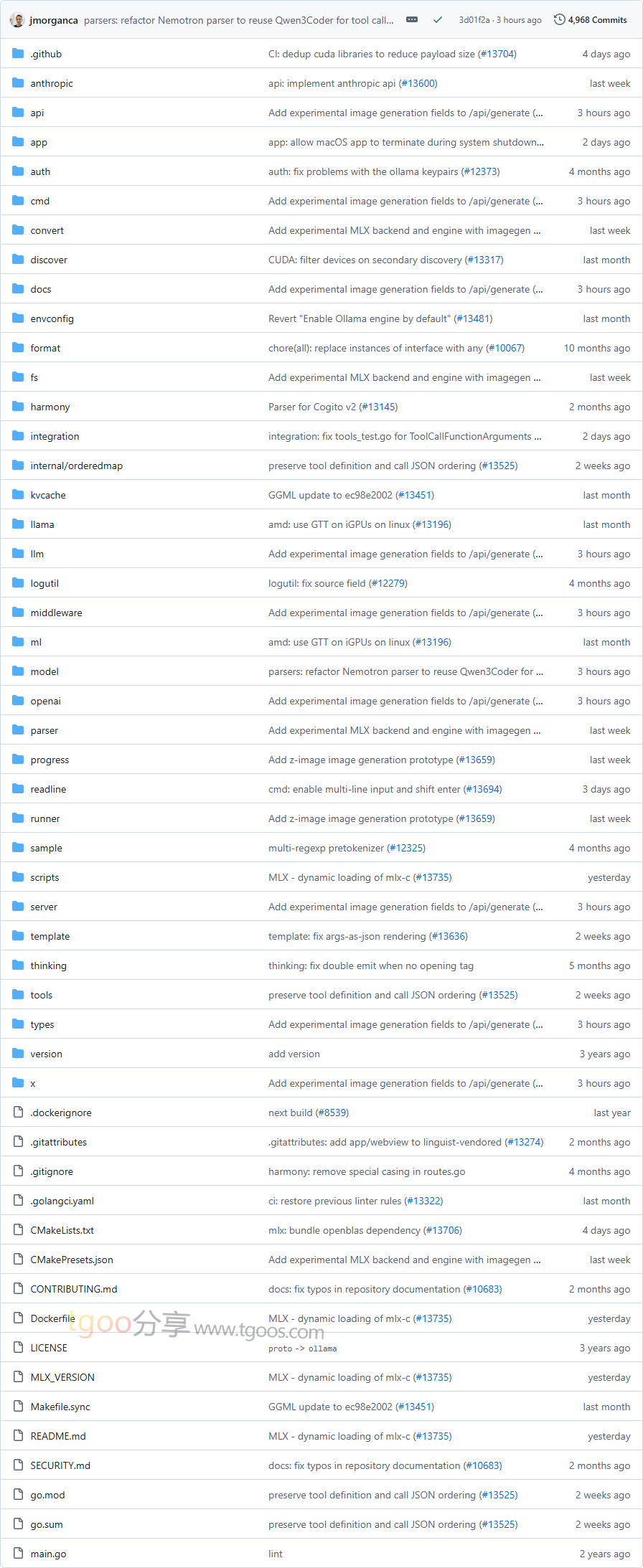

Ollama项目目录截图

Ollama项目核心亮点

- 🚀 极简部署:提供一键安装脚本和图形化桌面应用,无需复杂的环境配置,几分钟内即可启动并运行模型。

- 📦 丰富的模型库:内置官方模型库,支持从 Llama、Gemma、Mistral 到 DeepSeek 等数十种热门开源模型,并支持导入自定义的 GGUF 或 Safetensors 格式模型。

- 🔧 强大的定制能力:通过简单的

Modelfile配置文件,用户可以轻松定制模型的系统提示词、调整温度等参数,甚至创建具有特定角色(如“马里奥”)的个性化模型。 - 🌐 完善的生态系统:提供直观的 CLI、完整的 REST API 以及活跃的社区支持,拥有数百个第三方客户端、库和插件,可无缝集成到 Web、桌面、移动端、IDE 乃至 Discord 和 Obsidian 等应用中。

Ollama项目快速开始

只需几步,你就能在本地与 AI 模型对话:

安装:

# 对于 Linux 和 macOS (通过脚本安装)

$ curl -fsSL https://ollama.com/install.sh | shWindows 和 macOS 用户也可直接从官网下载桌面应用程序。

拉取并运行你的第一个模型:

# 拉取一个轻量级模型,例如 Gemma 3 1B 版本

$ ollama pull gemma3:1b

# 运行模型并开始交互式对话

$ ollama run gemma3:1b通过 API 调用:

# 使用 curl 调用 REST API 生成文本

$ curl http://localhost:11434/api/generate -d {

"model": "llama3.2",

"prompt": "为什么天空是蓝色的?"

}Ollama项目应用场景

- 本地AI助手与聊天:在完全离线的环境下,使用模型进行对话、头脑风暴、写作辅助或编程问答,保障数据隐私。

- 应用开发与集成:开发者可利用其 REST API 或各种客户端库(Python, JavaScript, Go, Java等),快速将 LLM 能力集成到自己的应用程序、机器人或工作流中。

- 模型研究与实验:研究人员和学生可以方便地在本地测试不同模型的表现、进行提示工程(Prompt Engineering)实验或微调自定义模型。

- 企业级私有化部署:结合 Docker 或 Kubernetes,在企业内网安全地部署 Ollama 服务,为内部工具提供AI能力,避免数据出域风险。

用户案例:目前,Ollama 已被广泛应用于个人项目、初创公司乃至大型企业的内部工具链中,其活跃的社区生态涵盖了从 Open WebUI、Continue(IDE插件)到 LangChain、LlamaIndex 等主流AI框架的集成。

Ollama项目链接

ollama / ollama项目地址:https://github.com/ollama/ollama

本文地址:https://www.tgoos.com/31278

声明:本站资源均整理自互联网,版权归原作者所有,仅供学习交流使用,请勿直接商用,若需商用请购买正版授权。因违规使用产生的版权及法律责任由使用者自负。部分资源可能包含水印或引流信息,请自行甄别。若链接失效可联系站长尝试补链。若侵犯您的权益,请邮件(将 # 替换为 @)至 feedback#tgoos.com,我们将及时处理删除。转载请保留原文链接,感谢支持原创。