MLX LM:在 Apple 芯片上高效运行和微调大语言模型

你是否曾经希望在 Mac 设备上本地运行和微调大语言模型(LLM),却受限于性能或兼容性问题?MLX LM 的出现,旨在彻底解决这个问题。它是一个基于 MLX 框架的 Python 包,专为 Apple 芯片优化,让开发者能够轻松生成文本、量化模型并进行分布式微调。本文将带你全面了解这个潜力新星。

截至收录:

MLX LM 项目 stars 数:2165

MLX LM 项目 forks 数:239

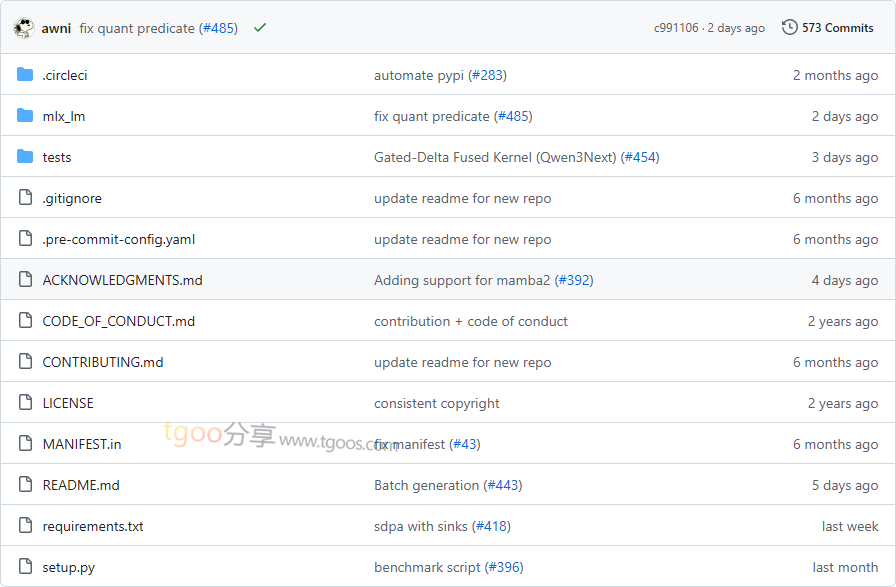

MLX LM 项目目录截图

MLX LM 核心亮点

🌟 与 Hugging Face 深度集成:支持数千个预训练模型,通过一条命令即可调用,极大简化了模型的使用和分发流程。

🎯 量化与模型上传:支持模型量化(如 4-bit 量化),并可将量化后的模型一键上传至 Hugging Face Hub,方便共享和部署。

🔒 高效的微调支持:提供全模型微调和低秩微调(LoRA),同时支持量化模型的微调,兼顾性能与资源效率。

🧩 分布式推理与训练:通过 mx.distributed 实现分布式推理和微调,充分发挥多设备协同计算的能力。

MLX LM 快速开始

只需几步,你就能在本地运行起 MLX LM:

1. 安装:

# 使用 pip 安装

$ pip install mlx-lm

# 或使用 conda 安装

$ conda install -c conda-forge mlx-lm- 生成你的第一段文本:

$ mlx_lm.generate --prompt "How tall is Mt Everest?" - 与模型交互式聊天:

$ mlx_lm.chat

MLX LM 应用场景

场景一:本地模型推理与聊天:开发者可以在 Apple 设备上快速运行 Mistral、Llama 等主流 LLM,进行文本生成或多轮对话,无需依赖云端服务。

场景二:模型量化与分发:研究人员可通过 MLX LM 将模型量化并上传至 Hugging Face Hub,实现轻量化部署和团队协作。

场景三:长文本处理与提示缓存:支持旋转 KV 缓存和提示缓存,适合处理长上下文任务,如文档总结、代码生成等。

用户案例:目前,MLX LM 已被广泛应用于学术研究、个人项目以及企业级原型开发中,成为 Apple 生态中运行 LLM 的首选工具之一。

MLX LM 链接

ml-explore / mlx-lm项目地址:https://github.com/ml-explore/mlx-lm

本文地址:https://www.tgoos.com/10711