OM1:模块化AI运行时,让机器人开发更简单高效

你是否曾经为机器人开发中复杂的系统集成、多模态数据处理和硬件适配问题而头疼?OpenMind的OM1正是为了解决这些痛点而生。它是一个基于Python的模块化AI运行时,旨在帮助开发者轻松创建和部署跨数字环境与物理机器人的多模态AI智能体。无论是人形机器人、手机应用、网站、四足机器人还是教育机器人如TurtleBot 4,OM1都能提供统一而强大的支持。

截至收录:

OM1项目stars数:465

OM1项目forks数:97

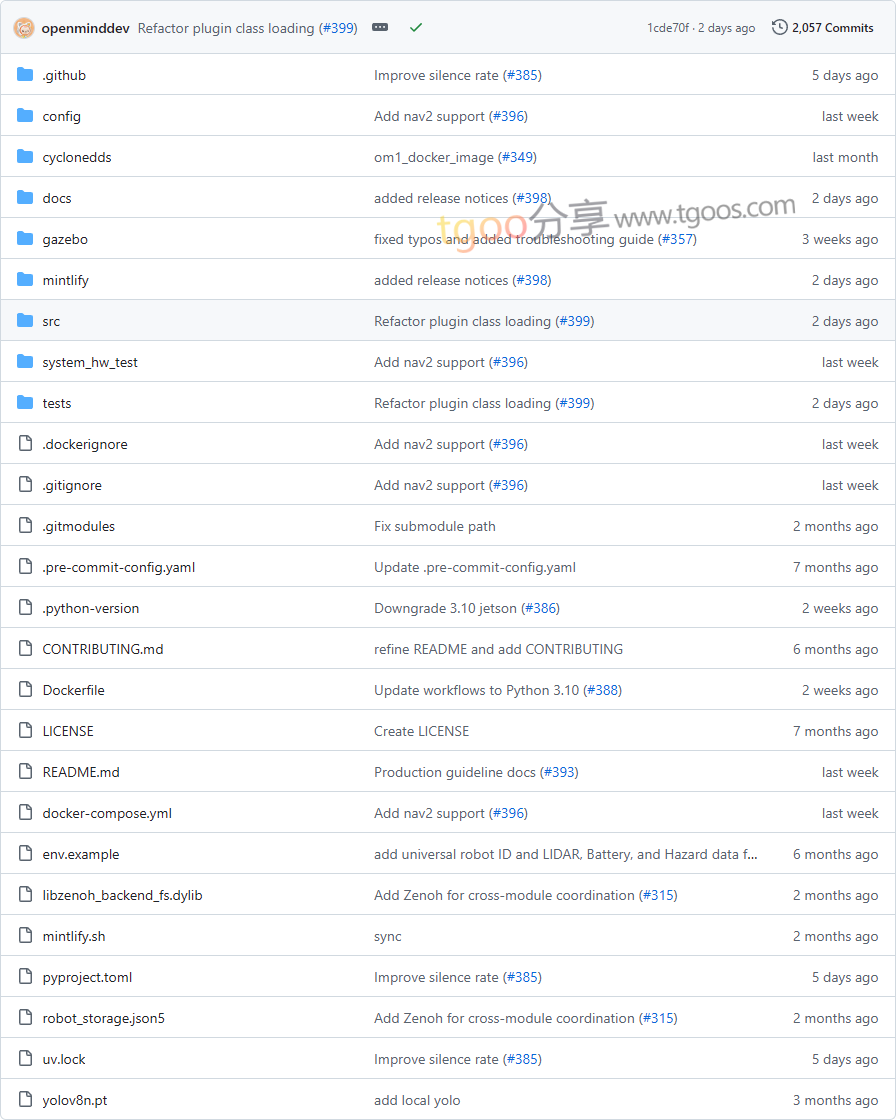

OM1项目目录截图

OM1核心亮点

🌟 模块化架构:基于Python设计,提供简洁的接口和无缝的集成体验,让开发者可以灵活组合功能模块。

🎯 多模态数据处理:支持处理网页数据、社交媒体、摄像头输入、LIDAR等多种输入,并能够执行运动、自主导航和自然对话等物理动作。

🔒 硬件插件支持:通过插件机制支持ROS2、Zenoh和CycloneDDS等机器人硬件连接,轻松适配不同硬件平台。

🧩 开箱即用的预配置服务:内置语音转文本、OpenAI GPT-4o、DeepSeek及多种视觉语言模型(VLM)的预配置端点,极大降低开发门槛。

OM1快速开始

只需几步,你就可以在本地运行一个功能完整的Spot智能体,体验OM1的强大能力:

- 安装依赖:

首先确保已安装uv包管理器,然后克隆项目并初始化子模块:git clone https://github.com/openmind/OM1.git cd OM1 git submodule update --init uv venv - 安装系统依赖:

根据你的操作系统安装必要的库: - MacOS:

brew install portaudio ffmpeg - Linux:

sudo apt-get update sudo apt-get install portaudio19-dev python-dev ffmpeg - 配置API密钥:

在OpenMind门户获取API密钥,并将其添加到config/spot.json5或.env文件中。 - 运行示例:

uv run src/run.py spot运行后,Spot智能体会通过摄像头捕捉并识别物体,通过OpenAI 4o生成动作和语音反馈,并在WebSim界面中实时展示。

OM1应用场景

场景一:教育机器人开发:教育机构可以使用OM1快速构建交互式教学机器人,支持自然语言对话和视觉识别功能。

场景二:智能家居与服务机器人:开发者可以基于OM1创建具备自主导航、多模态感知能力的家庭服务机器人。

场景三:工业自动化:通过OM1的硬件插件机制,企业可以将其应用于工业环境中的自动化检测和操作任务。

用户案例:目前,OM1已被多个研究机构和机器人开发者用于原型开发和教育项目,其模块化设计使得从概念验证到实际部署的流程大大简化。

OM1项目链接

OpenMind / OM1项目地址:https://github.com/OpenMind/OM1

注意:本文内容基于项目现有文档撰写,具体实现细节和最新功能请以官方文档和代码库为准。

本文地址:https://www.tgoos.com/11096