Unsloth:让大语言模型微调速度翻倍、显存节省70%的高效框架

你是否曾经因为大语言模型微调过程缓慢、显存占用巨大而头疼?Unsloth 的出现,旨在彻底解决这个问题。它是一个基于 Python 的高性能微调加速框架,可以帮助开发者和研究者以 2 倍的速度、70% 的显存占用量完成模型训练。本文将带你全面了解这个潜力新星。

截至收录:

Unsloth项目stars数:45928

Unsloth项目forks数:3752

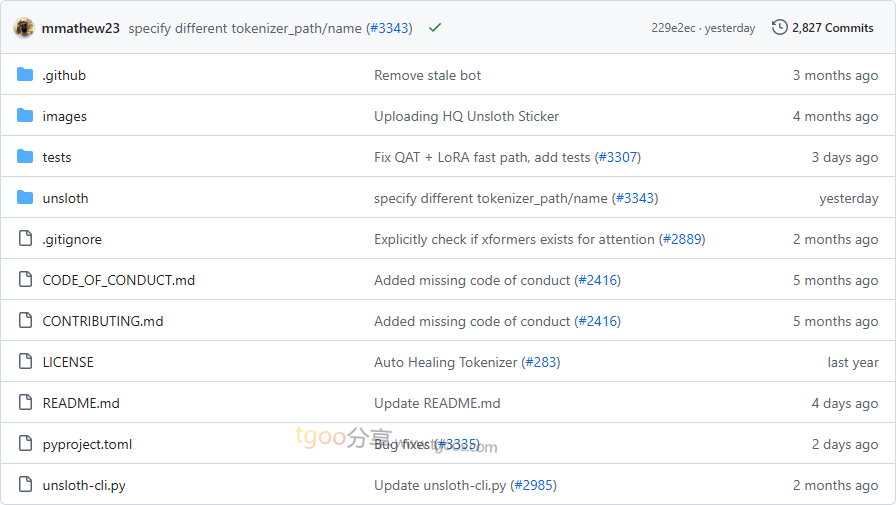

Unsloth项目目录截图

Unsloth核心亮点

🚀 极致性能优化:通过手动编写的 Triton 内核和优化的反向传播引擎,训练速度提升 2 倍,显存占用降低 70%。

🎯 开箱即用体验:提供大量预配置的 Notebook,用户只需添加数据集、点击运行,即可导出微调后的模型。

🔒 精确无损训练:采用精确计算方法,无需近似优化,保证模型精度 0% 损失。

🧩 广泛模型支持:支持全参数微调、4/8/16 比特训练,涵盖 Transformer 类模型、TTS、多模态、BERT 等各类架构。

Unsloth快速开始

只需几步,你就能在本地运行起 Unsloth:

- 安装(Linux/WSL):

pip install unsloth - 加载模型并配置训练:

from unsloth import FastLanguageModel model, tokenizer = FastLanguageModel.from_pretrained( model_name="unsloth/gemma-3-4B-it", load_in_4bit=True, max_seq_length=2048, ) model = FastLanguageModel.get_peft_model(model, lora_alpha=16, r=16) - 启动训练循环:

from trl import SFTTrainer trainer = SFTTrainer(model=model, train_dataset=dataset, args=training_args) trainer.train()

Unsloth应用场景

场景一:高效模型微调:研究者可使用 Unsloth 在消费级 GPU 上微调大规模模型(如 Llama 3.3 70B),大幅降低硬件门槛。

场景二:强化学习训练:支持 DPO、GRPO、PPO 等多种强化学习算法,适用于对话模型的对齐和优化。

用户案例:目前,Unsloth 已被集成至 Hugging Face 官方文档,并被多个研究团队和企业用于加速模型迭代和实验。

Unsloth链接

unslothai / unsloth项目地址:https://github.com/unslothai/unsloth

本文地址:https://www.tgoos.com/11496