KTransformers:释放CPU/GPU混合推理潜力的前沿框架

你是否曾经为大型语言模型(尤其是MoE模型)的推理速度慢、资源消耗大而苦恼?KTransformers的出现,旨在彻底解决这个问题。它是一个专注于CPU-GPU异构计算的LLM高效推理与微调框架,可以帮助开发者和研究者在有限硬件资源下实现数倍性能提升。本文将带你全面了解这个潜力新星。

截至收录:

KTransformers项目stars数:16012

KTransformers项目forks数:1166

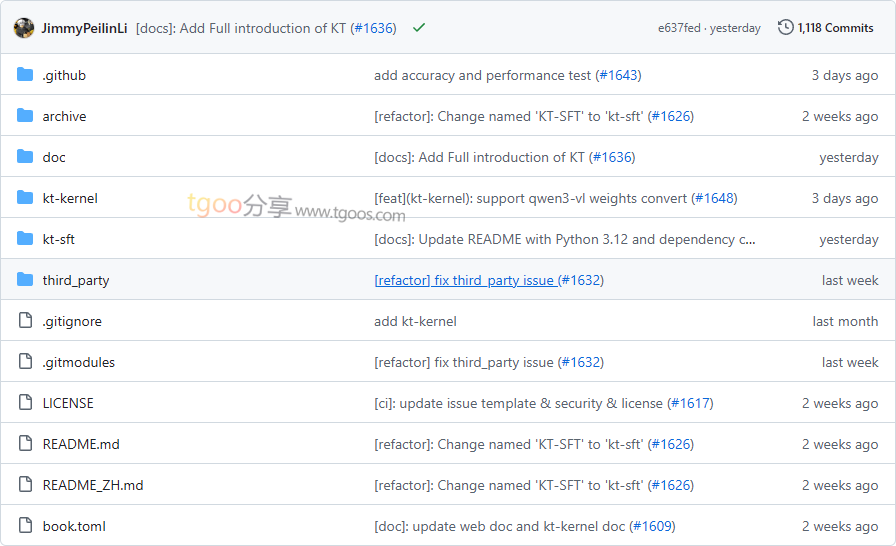

KTransformers项目目录截图

KTransformers项目核心亮点

🚀 极致性能优化:通过AMX/AVX指令集加速,支持INT4/INT8量化推理,在CPU-GPU混合架构下实现高达3-28倍的推理加速。

🎯 MoE模型专精:针对混合专家模型进行深度优化,支持NUMA感知内存管理和异构专家部署(热专家在GPU,冷专家在CPU)。

🔧 无缝框架集成:与SGLang、LLaMA-Factory等流行框架深度集成,提供简洁的Python API,开箱即用。

💾 资源效率革命:仅需70GB GPU内存+1.3TB RAM即可微调671B参数的DeepSeek-V3模型,大幅降低大模型使用门槛。

KTransformers项目快速开始

只需几步,你就能体验KTransformers的强大性能:

- 安装kt-kernel:

cd kt-kernel pip install . - 体验微调功能:

cd kt-sft USE_KT=1 llamafactory-cli train examples/train_lora/deepseek3_lora_sft_kt.yaml - 查看性能示例:

# 运行示例代码体验高性能推理 python examples/inference_demo.py

KTransformers项目应用场景

场景一:大规模MoE模型推理:研究机构和企业可以使用KTransformers在有限硬件资源下部署千亿参数级别的MoE模型,实现生产级推理性能。

场景二:资源受限的模型微调:开发者能够在单机多卡环境下微调超大规模语言模型,大幅降低实验成本和时间。

场景三:异构计算研究:学术界可以利用该框架探索CPU-GPU混合计算在LLM领域的新可能,推动算法与硬件的协同优化。

用户案例:目前,该框架已被MADSys Lab @ Tsinghua University、Approaching.AI等多个知名研究机构和团队采用,在DeepSeek-V3、DeepSeek-R1等最新模型上取得了显著性能提升。

KTransformers项目链接

kvcache-ai / ktransformers项目地址:https://github.com/kvcache-ai/ktransformers

本文地址:https://www.tgoos.com/25015