Minima:本地化可配置的对话式 RAG 容器解决方案

你是否曾经为在本地安全地处理文档检索与生成任务而烦恼?Minima 的出现,旨在彻底解决这个问题。它是一个开源的、基于容器的本地 RAG(检索增强生成)系统,支持与 ChatGPT 和 MCP(模型上下文协议)集成,让开发者能够在完全本地或混合云环境中灵活部署智能文档问答应用。本文将带你全面了解这个潜力新星。

截至收录:

Minima项目stars数:1017

Minima项目forks数:98

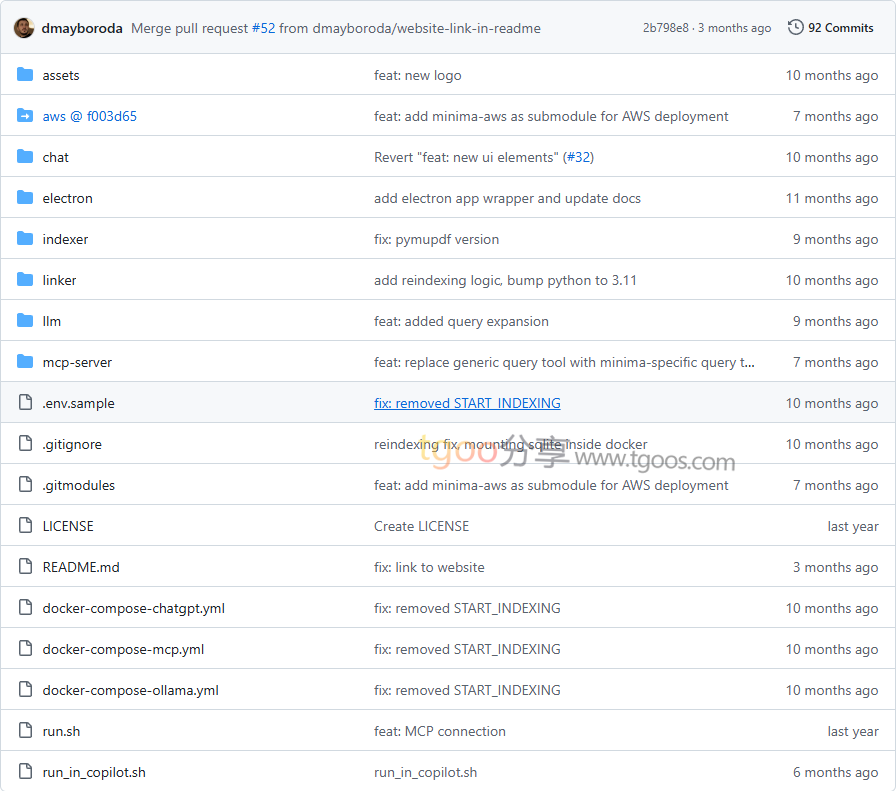

Minima项目目录截图

Minima项目核心亮点

- 🏠 完全本地化部署:支持纯本地容器化运行,所有神经网络(LLM、重排序器、嵌入模型)都在你的云环境或 PC 上运行,确保数据安全不外泄。

- 🔄 灵活的集成模式:提供三种运行模式——完全本地、ChatGPT 集成和 Anthropic Claude 集成,满足不同场景需求。

- 🔧 容器化一键部署:基于 Docker Compose 的标准化部署流程,简化了复杂的 RAG 系统配置。

- 📄 多格式文档支持:支持 PDF、Excel、Word、文本、Markdown、CSV 等多种常见文档格式的自动索引。

Minima项目快速开始

只需几步,你就能在本地运行起 Minima:

- 环境配置:

在项目根目录创建.env文件,配置必要的环境变量:LOCAL_FILES_PATH=/your/local/files/path/ EMBEDDING_MODEL_ID=sentence-transformers/all-mpnet-base-v2 EMBEDDING_SIZE=768 OLLAMA_MODEL=qwen2:0.5b RERANKER_MODEL=BAAI/bge-reranker-base - 选择模式启动:

# 完全本地模式 $ docker compose -f docker-compose-ollama.yml --env-file .env up --build # ChatGPT 集成模式 $ docker compose -f docker-compose-chatgpt.yml --env-file .env up --build # MCP 集成模式 $ docker compose -f docker-compose-mcp.yml --env-file .env up --build - 访问应用:

启动后访问http://localhost:3000即可使用聊天界面。

Minima项目应用场景

- 企业知识库管理:在本地构建安全的企业文档问答系统,保护敏感数据不外泄。

- 开发文档助手:集成到 Claude Desktop 或 VS Code 中,快速查询本地技术文档和代码库。

- 个人文档检索:为个人收藏的 PDF、文档建立智能检索系统,实现自然语言问答。

- 混合云智能应用:在保持数据本地的同时,利用云端大模型的强大能力。

Minima项目链接

dmayboroda / minima项目地址:https://github.com/dmayboroda/minima

本文地址:https://www.tgoos.com/26075

声明:本站资源均整理自互联网,版权归原作者所有,仅供学习交流使用,请勿直接商用,若需商用请购买正版授权。因违规使用产生的版权及法律责任由使用者自负。部分资源可能包含水印或引流信息,请自行甄别。若链接失效可联系站长尝试补链。若侵犯您的权益,请邮件(将 # 替换为 @)至 feedback#tgoos.com,我们将及时处理删除。转载请保留原文链接,感谢支持原创。