BitNet:高效运行1位大语言模型的官方推理框架

你是否曾经因为大语言模型的高计算需求和能耗问题而无法在本地设备上流畅运行AI应用?BitNet的出现,旨在彻底解决这个问题。它是一个由微软开发的1位大语言模型高效推理框架,可以帮助开发者在CPU和GPU上实现快速、无损的1.58位模型推理。本文将带你全面了解这个革命性的推理框架。

截至收录:

BitNet项目stars数:21772

BitNet项目forks数:1659

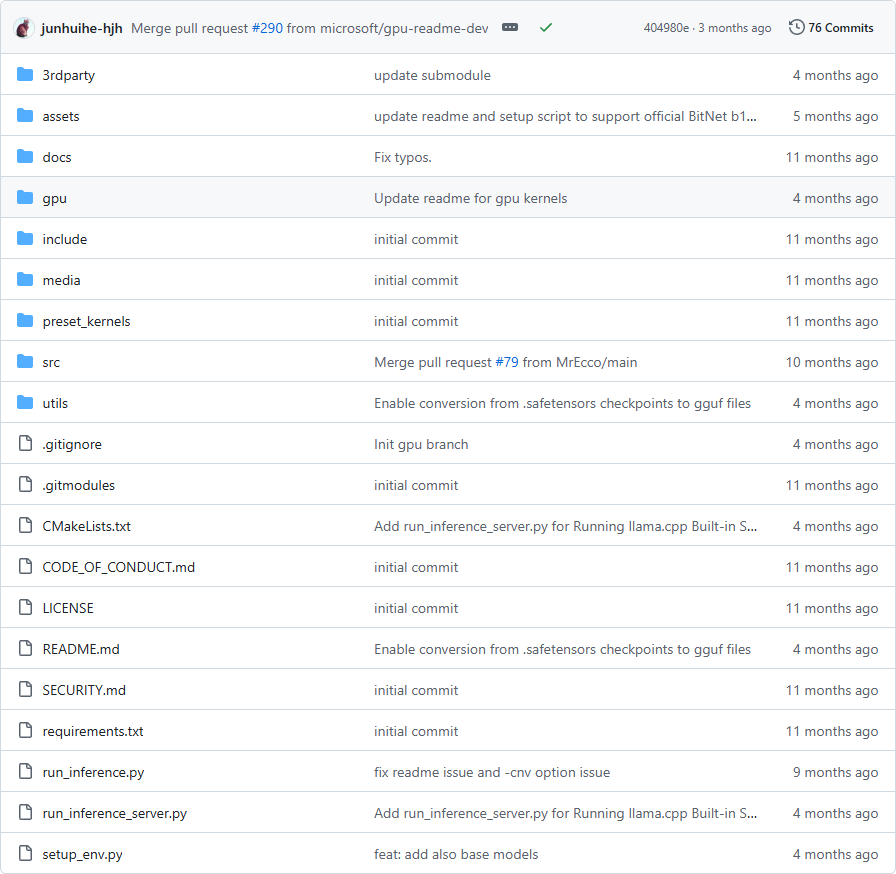

BitNet项目目录截图

BitNet核心亮点

🚀 极致性能优化:在ARM CPU上实现1.37x到5.07x的加速,x86 CPU上实现2.37x到6.17x的加速,大幅提升推理效率。

🔋 显著能耗降低:ARM架构能耗降低55.4%到70.0%,x86架构能耗降低71.9%到82.2%,大幅提升能效比。

💻 单CPU运行百亿模型:支持在单个CPU上运行100B参数的BitNet b1.58模型,生成速度达到5-7 tokens/秒,媲美人类阅读速度。

🎯 多平台支持:全面支持CPU和GPU推理(NPU支持即将到来),提供优化的内核实现。

BitNet快速开始

只需几步,你就能在本地运行起BitNet:

环境准备:

# 克隆项目git clone --recursive https://github.com/microsoft/BitNet.gitcd BitNet创建conda环境(推荐)conda create -n bitnet-cpp python=3.9

conda activate bitnet-cpp

安装依赖

pip install -r requirements.txt

下载并运行模型:

# 下载官方模型

huggingface-cli download microsoft/BitNet-b1.58-2B-4T-gguf –local-dir models/BitNet-b1.58-2B-4T

# 运行推理

python run_inference.py -m models/BitNet-b1.58-2B-4T/ggml-model-i2_s.gguf -p “You are a helpful assistant” -cnv

BitNet应用场景

边缘设备部署:开发者可以在资源受限的边缘设备上部署大型语言模型,实现本地化的AI应用。

节能AI推理:企业和研究机构可以利用BitNet大幅降低AI推理的能耗成本,实现绿色计算。

移动端AI应用:移动应用开发者可以在智能手机等设备上集成大语言模型能力,提供离线AI服务。

原型快速验证:研究人员可以快速在本地环境中验证和测试1位大语言模型的性能表现。

用户案例:目前,微软官方模型、Falcon3系列模型、Llama3-8B-1.58等都在使用BitNet框架进行高效推理。

BitNet项目链接

BitNet作为1位大语言模型领域的官方推理框架,不仅提供了卓越的性能表现,更重要的是降低了大型语言模型的部署门槛,让更多的开发者和企业能够在资源受限的环境中享受AI技术带来的便利。无论是学术研究还是商业应用,BitNet都展现出了巨大的潜力和价值。

microsoft / BitNet项目地址:https://github.com/microsoft/BitNet

本文地址:https://www.tgoos.com/7939