TensorZero:工业级LLM应用的全栈开源解决方案

你是否曾经为构建生产级LLM应用时的网关管理、可观测性、优化和评估而头疼?TensorZero的出现,旨在彻底解决这个问题。它是一个用Rust编写的高性能开源全栈平台,可以帮助开发者统一管理LLM网关、实现深度可观测性、进行模型优化与评估,并支持安全可靠的实验部署。本文将带你全面了解这个潜力新星。

截至收录:

TensorZero项目stars数:10128

TensorZero项目forks数:673

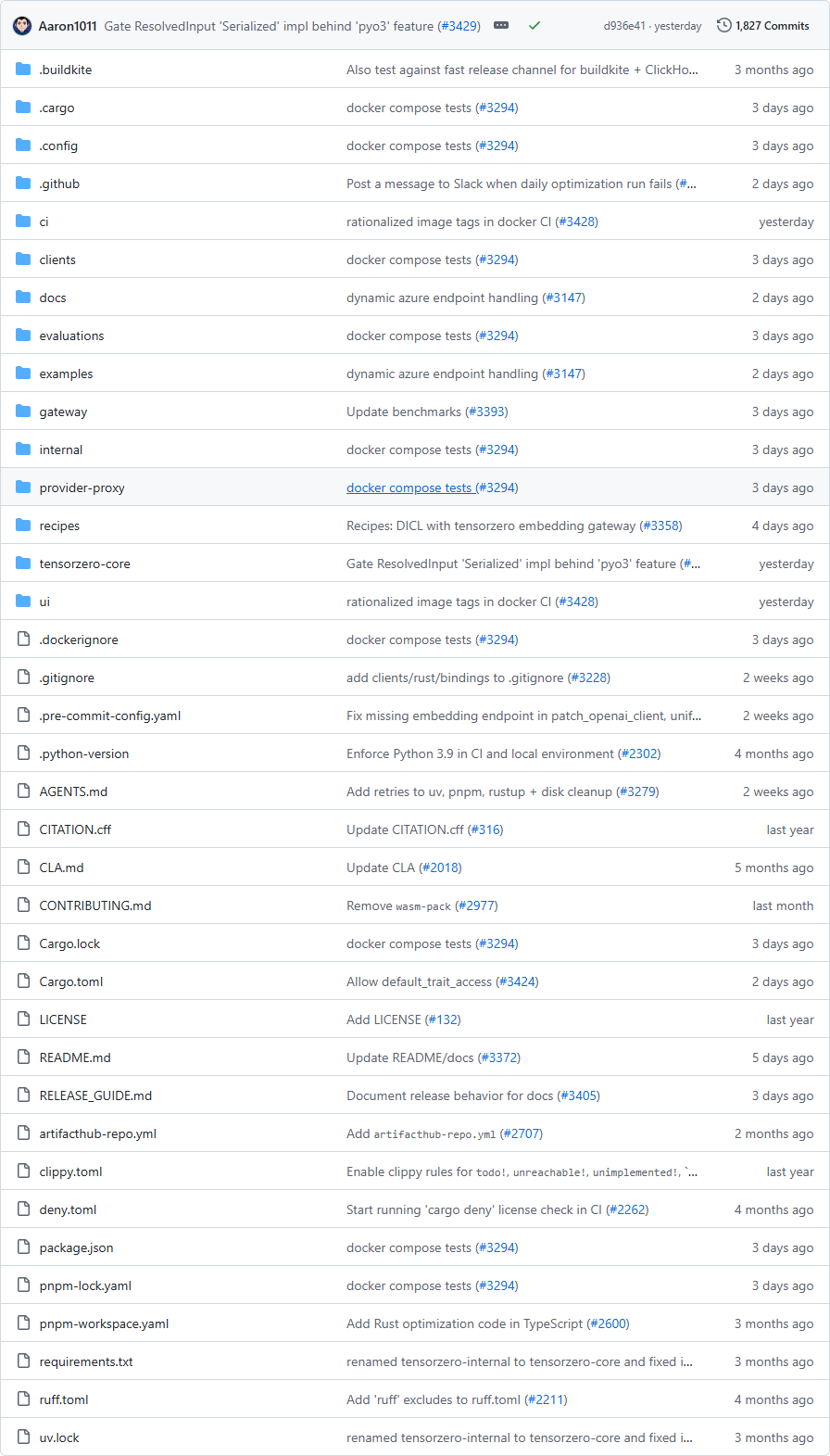

TensorZero项目目录截图

TensorZero核心亮点

🌐 统一LLM网关:通过单一API接入所有主流LLM提供商,支持流式推理、工具调用、结构化生成等高级功能,基于Rust实现极致性能(P99延迟<1ms,支持10k+ QPS)。

🔍 深度可观测性:将所有推理数据和反馈存储于自有数据库,支持UI界面和程序化查询,帮助开发者深入分析每一次调用或宏观监控模型表现。

📈 智能优化引擎:结合生产指标和人工反馈,优化提示词、模型及推理策略,支持监督微调、RLHF、自动化提示工程(如MIPROv2)等多种优化方法。

🧪 内置实验框架:提供A/B测试、路由策略、故障回退和重试机制,支持复杂多步LLM系统的严格实验设计(RCTs),让发布更自信。

TensorZero快速开始

只需几步,你就能在本地运行起 TensorZero:

- 安装(通过Python客户端):

- 运行你的第一个推理:

from tensorzero import TensorZeroGatewaywith TensorZeroGateway.build_embedded(clickhouse_url="...", config_file="...") as client:

response = client.inference(

model_name="openai::gpt-4o-mini",

input={

"messages": [{"role": "user", "content": "写一首关于人工智能的俳句。"}]

}

)

- 查看示例项目:

访问项目GitHub仓库中的Examples板块,体验从数据提取优化到多跳问答的完整案例。

pip install tensorzero

TensorZero应用场景

场景一:企业级LLM网关部署

开发者可通过TensorZero统一接入Anthropic、OpenAI、Azure、Bedrock等20+提供商,并享受<1ms的延迟开销和高可用保障(自动路由、回退和负载均衡)。

场景二:生产环境下的模型优化与评估

数据团队可以使用TensorZero收集推理指标和人工反馈,优化提示工程或微调模型,并通过内置评估框架(启发式或LLM评判员)对比不同策略效果。

用户案例:目前,某大型银行已采用TensorZero自动化代码变更日志生成,提升了开发流程的智能化水平。TensorZero也受到多家AI实验室和开源项目投资者的支持。

TensorZero链接

tensorzero / tensorzero项目地址:https://github.com/tensorzero/tensorzero

本文地址:https://www.tgoos.com/7934