Tunix:基于JAX的大语言模型后训练库

你是否曾经为大型语言模型的后训练过程感到头疼?复杂的配置、低效的计算和难以扩展的架构让人望而却步?Tunix的出现,旨在彻底解决这些问题。它是一个基于JAX原生开发的大语言模型后训练库,可以帮助开发者高效、灵活地进行模型微调、强化学习和知识蒸馏。本文将带你全面了解这个来自Google的潜力项目。

截至收录:

Tunix项目stars数:1477

Tunix项目forks数:129

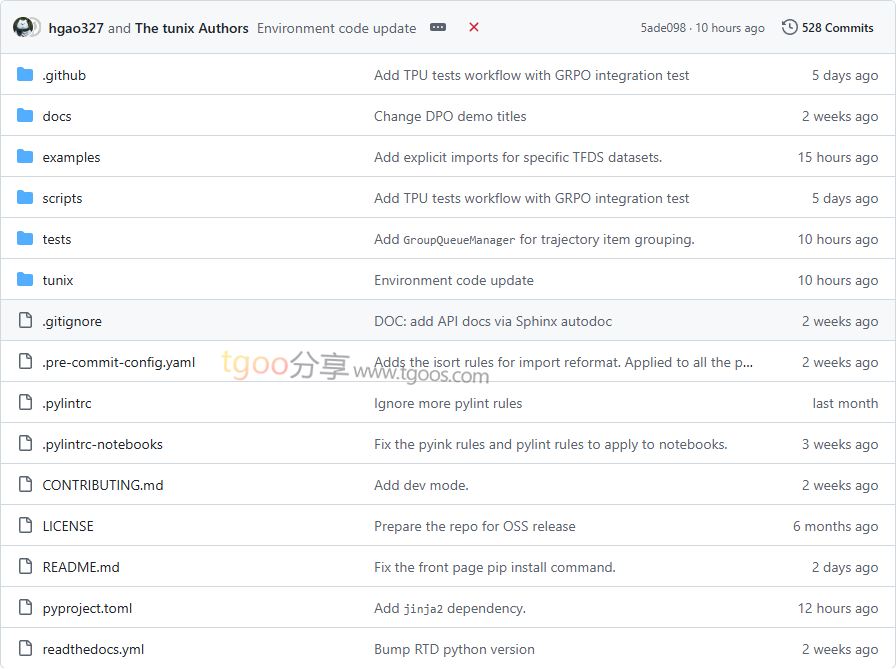

Tunix项目目录截图

Tunix项目核心亮点

🚀 极致性能:基于JAX框架,充分利用TPU等加速器进行分布式训练,支持DP、FSDP和TP等模型分片策略。

🎯 算法丰富:提供监督微调、强化学习(PPO、GRPO、GSPO)、偏好对齐(DPO)和多种知识蒸馏策略。

🧩 模块化设计:组件高度可复用和可组合,便于用户自定义和扩展功能。

🔧 高效易用:支持参数高效微调(LoRA/Q-LoRA),简化训练流程,降低资源需求。

Tunix项目快速开始

只需几步,你就能开始使用Tunix进行模型训练:

- 安装:

# 推荐从PyPI安装 pip install "google-tunix[prod]"或从GitHub安装最新版本

pip install git+https://github.com/google/tunix - 运行示例:

# 查看项目提供的丰富示例 # - PEFT Gemma with QLoRA # - Training Gemma on grade school Math problems using GRPO # - Logit Distillation using Gemma models - 开发模式安装:

git clone https://github.com/google/tunix.git cd tunix pip install -e ".[dev]"

Tunix项目应用场景

场景一:模型监督微调:开发者可以使用Tunix对预训练模型进行全参数微调或参数高效微调,适应特定领域任务。

场景二:强化学习训练:支持PPO、GRPO等先进强化学习算法,用于对齐模型输出与人类偏好。

场景三:知识蒸馏:提供多种蒸馏策略,包括Logit蒸馏、注意力迁移等,帮助将大模型知识迁移到小模型。

用户案例:目前,Tunix已与UCSD Hao AI Lab的GRL框架深度合作,为社区提供强大的TPU支持强化学习实验环境。

Tunix项目链接

google / tunix项目地址:https://github.com/google/tunix

本文地址:https://www.tgoos.com/15176