OpenPI:开源的机器人视觉-语言-动作模型库

你是否曾经为机器人控制中的复杂感知-决策-执行 pipeline 感到头疼?OpenPI 的出现,旨在彻底解决这个问题。它是一个由 Physical Intelligence 团队发布的、基于 Python 的开源机器人模型与工具包,可以帮助研究者和开发者快速部署和微调先进的视觉-语言-动作(VLA)模型。本文将带你全面了解这个潜力新星。

截至收录:

OpenPI 项目 stars 数:6150

OpenPI 项目 forks 数:733

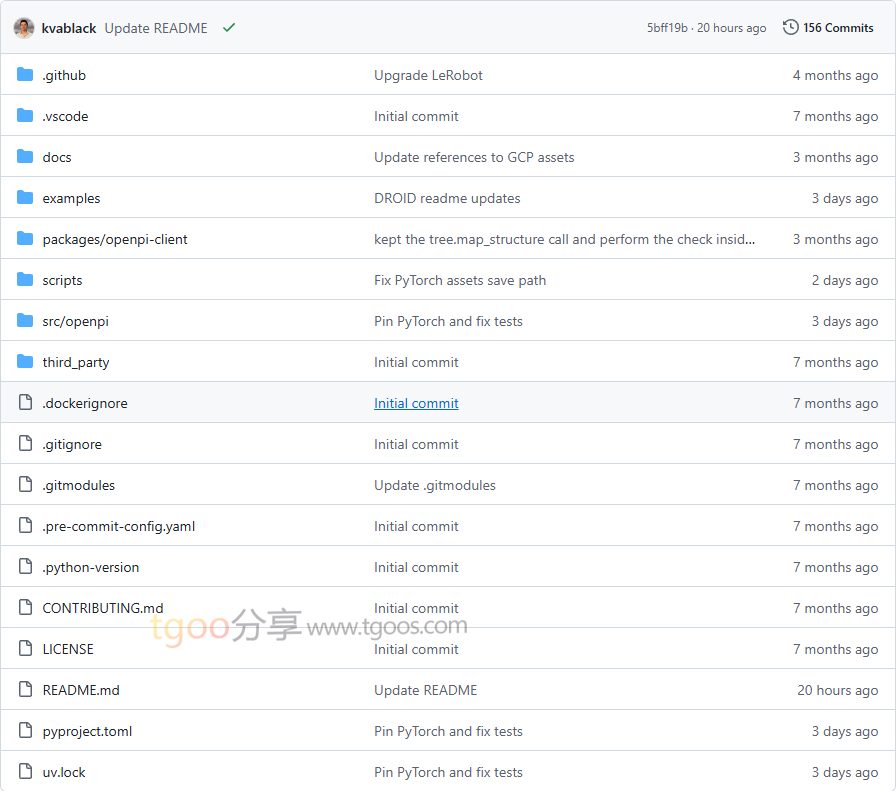

OpenPI 项目目录截图

OpenPI 核心亮点

🌟 多种先进模型架构:提供包括基于流的 π₀ 模型、自回归的 π₀-FAST 模型,以及具备更强泛化能力的 π₀.₅ 模型,满足不同场景需求。

🎯 海量预训练数据支持:所有基础模型均在超过 1 万小时的机器人数据上进行预训练,为下游任务提供强大基础。

🔒 灵活部署方案:支持本地推理、远程服务器推理,并提供完整的微调流程,适应从研究到实际部署的全流程。

🧩 多平台兼容:提供针对 DROID、ALOHA 等主流机器人平台的专用模型,并支持自定义数据微调。

OpenPI 快速开始

只需几步,你就能在本地运行起 OpenPI:

- 安装:

# 克隆仓库并初始化子模块 git clone --recurse-submodules git@github.com:Physical-Intelligence/openpi.git cd openpi # 使用 uv 安装依赖 GIT_LFS_SKIP_SMUDGE=1 uv sync GIT_LFS_SKIP_SMUDGE=1 uv pip install -e . - 运行推理示例:

from openpi.training import config as _config from openpi.policies import policy_config from openpi.shared import downloadconfig = _config.get_config("pi05_droid") checkpoint_dir = download.maybe_download("gs://openpi-assets/checkpoints/pi05_droid") policy = policy_config.create_trained_policy(config, checkpoint_dir) - 查看示例:

# 运行示例 notebook 了解完整流程 $ jupyter notebook examples/inference_demo.ipynb

OpenPI 应用场景

场景一:学术研究 benchmark:研究者可以使用 OpenPI 在 LIBERO 等标准测试集上快速复现和验证新算法,π₀.₅-LIBERO 模型在该 benchmark 上达到了 state-of-the-art 性能。

场景二:工业机器人部署:工程师可以基于预训练模型,使用自有数据快速微调,适配特定的生产线任务,如物品分拣、装配等。

场景三:教育演示与原型开发:学生和开发者可以利用提供的 ALOHA 仿真环境,快速搭建机器人演示系统,验证想法。

用户案例:目前,OpenPI 的模型已被应用于桌面操作任务(DROID)、毛巾折叠(ALOHA-towel)、食品容器开封(ALOHA-tupperware)等多个实际场景中。

OpenPI 项目链接

Physical-Intelligence / openpi项目地址:https://github.com/Physical-Intelligence/openpi

本文地址:https://www.tgoos.com/10111